Por que hardening em Kubernetes virou assunto obrigatório na nuvem em 2026

Kubernetes deixou de ser “coisa de time de plataforma” e virou infraestrutura padrão de muitas empresas, desde startups até bancos enormes. Com isso, os ataques também ficaram mais criados especificamente para explorar clusters mal configurados. Em 2026, não é mais raro ver incidentes em que um simples painel de métricas exposto abre a porta para mineradores de criptomoeda ou para vazamento de dados sensíveis. Hardening em Kubernetes não é só ligar meia dúzia de flags de segurança e dormir tranquilo; é uma forma de pensar o cluster como um conjunto de componentes que precisam ser cercados, observados e atualizados continuamente. A boa notícia é que dá para começar com passos bem objetivos, evitando decisões mirabolantes e reduzindo bastante a superfície de ataque, mesmo em ambientes que já estão rodando em produção há um bom tempo na nuvem pública ou híbrida.

Passo 1: começar pelo plano de controle e pelo acesso ao cluster

Quando se fala em configurações essenciais para clusters seguros na nuvem, quase sempre o papo começa pelos pods, mas o plano de controle é o verdadeiro “cérebro” do Kubernetes. Se alguém consegue chegar no kube-apiserver com privilégios de administrador, o jogo acaba ali. O primeiro cuidado é garantir que o cluster use autenticação forte, com integração de identidade corporativa (OIDC com um IdP confiável, por exemplo) e MFA para qualquer acesso administrativo. Evite usar certificados genéricos compartilhados ou contas estáticas com kubeconfig espalhado em laptops e pipelines sem controle. Em 2026, muitas empresas já tratam o acesso ao cluster como tratam VPN de produção: com revisão periódica, segregação de funções e trilha de auditoria completa, reduzindo bastante o risco de um simples vazamento de credenciais virar um desastre de segurança.

Passo 2: autorização, RBAC e o fim do “cluster-admin para todo mundo”

Depois de autenticar quem é quem, o próximo passo é limitar o que cada identidade pode fazer com RBAC bem pensado. Um erro ainda muito comum é dar “cluster-admin” para times inteiros, só porque é mais rápido do que entender todas as regras de Role e ClusterRole. Esse atalho funciona até o dia em que um pipeline comprometido ou um desenvolvedor distraído cria um recurso expondo dados sensíveis ou abrindo todas as portas possíveis no cluster. Vale a pena separar identidades de pessoa, de serviço e de automação, dando apenas as permissões necessárias a cada uma. Um time de aplicação geralmente não precisa criar namespaces, mexer em StorageClass ou alterar configuração do Ingress Controller. Para quem está começando e se sente travado com RBAC, uma dica prática é partir de perfis pré-definidos de consultoria em hardening de kubernetes para empresas ou de benchmarks como CIS, adaptando o que fizer sentido para a sua realidade, em vez de tentar desenhar tudo do zero sem referência.

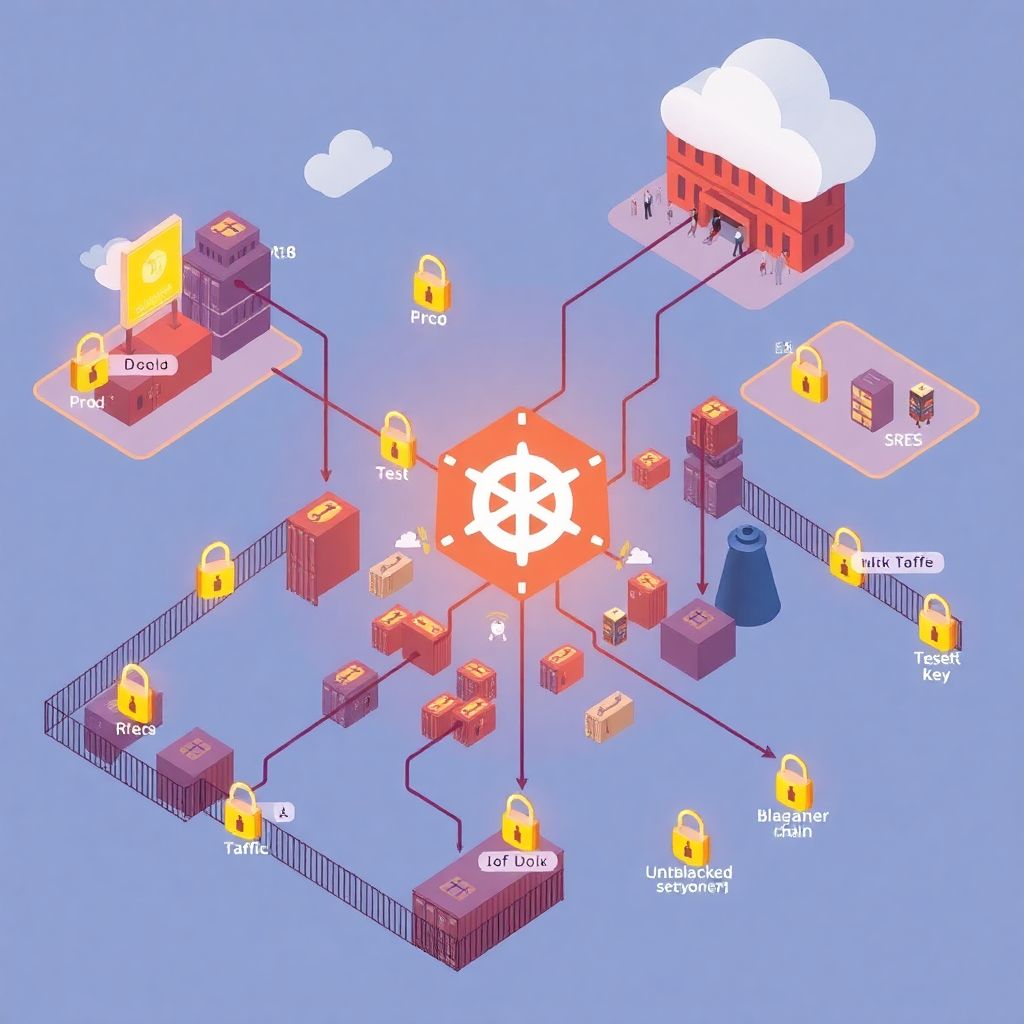

Passo 3: isolamento por namespaces, quotas e políticas de rede

Com a parte de identidade organizada, vem o isolamento interno. Nem todo mundo percebe, mas namespaces não são só pastas lógicas; eles ajudam a separar contextos de segurança. Em clusters multi-tenant, misturar ambientes de teste e produção no mesmo namespace é pedir para sofrer, porque qualquer erro de configuração pode afetar workloads críticos. A combinação de namespaces bem definidos com ResourceQuota, LimitRange e políticas de rede cria “cercadinhos” bem claros. Policies de rede são especialmente importantes: sem elas, todo pod conversa com todo mundo, o que transforma qualquer comprometimento em algo muito mais grave. O ideal é partir de um modelo “default deny” e ir liberando apenas o tráfego realmente necessário, usando rótulos bem pensados e documentação interna clara, para que os times não se sintam completamente perdidos ao depurar problemas de comunicação entre serviços.

Passo 4: admission controllers, Pod Security e políticas obrigatórias

Chega um momento em que você percebe que só confiar que os times “vão seguir as boas práticas” não escala. Admission controllers são o ponto em que o cluster pode dizer “isso aqui não entra”. Em vez de esperar até que alguém suba um contêiner privilegiado em produção, você instala políticas que bloqueiam esse tipo de configuração na porta de entrada. Com as novas capacidades de Pod Security no Kubernetes, somadas a soluções de policy-as-code baseadas em Open Policy Agent (OPA) ou similares, é possível exigir que todos os pods usem imagens de um registry confiável, que não rodem como root e que tenham requests e limits configurados. O truque para não virar vilão da história é começar monitorando em modo “audit” e só depois migrar gradualmente para “enforce”, avisando os times, trazendo exemplos e ajudando a adaptar manifests, em vez de simplesmente quebrar todos os deploys de uma vez.

Passo 5: imagens, registries e supply chain sob controle

Hardening de verdade passa bastante por cuidar do que entra no cluster em forma de imagem de contêiner. De nada adianta ter políticas perfeitas se você baixa imagens aleatórias de registries públicos sem saber o que tem dentro. Em 2026, práticas como assinar imagens, usar scanners de vulnerabilidade e bloquear tags “latest” em produção já são consideradas básicas em ambientes mais maduros. Dá para integrar scanners como parte do pipeline de CI, falhando builds quando são encontradas falhas críticas que ainda não têm mitigação aceitável. Um cuidado adicional é garantir que o registry privado seja acessível apenas pelo cluster e por pipelines autorizados, evitando exposição direta na internet. Em cenários mais regulados, a auditoria e compliance de kubernetes em ambiente cloud costuma exigir evidência de que imagens foram avaliadas, atualizadas e aprovadas antes de entrar em produção, reforçando a necessidade de um processo bem definido de gestão de versões.

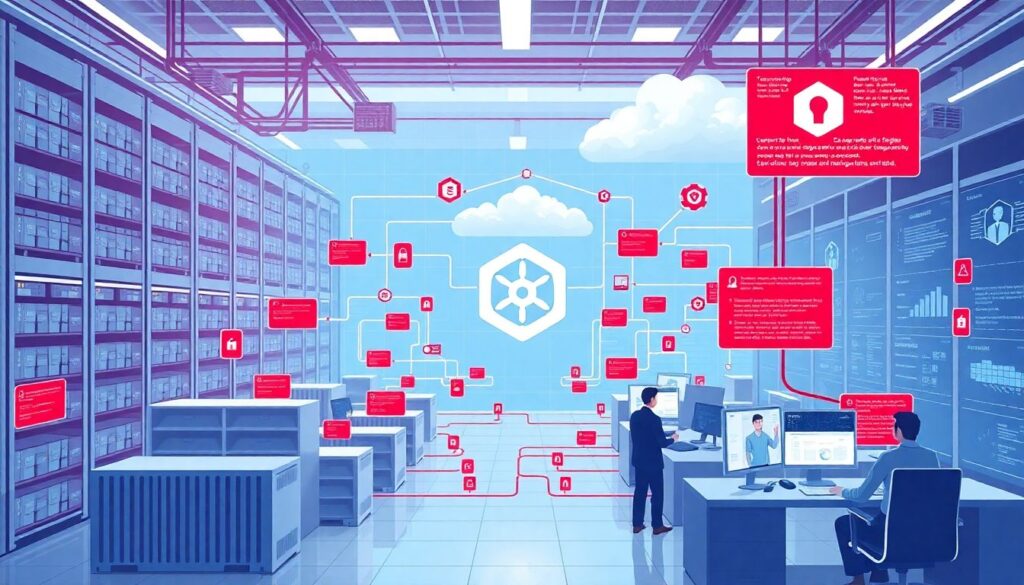

Passo 6: observabilidade, logs, detecção e resposta a incidentes

Mesmo o cluster mais bem reforçado do mundo não está imune a falhas humanas nem a vulnerabilidades zero-day. Por isso, proteger também significa enxergar o que está acontecendo e reagir rápido. Ter logs de audit do Kubernetes enviados para um backend central, com retenção adequada, facilita tanto investigações de incidentes quanto a comprovação de controles em auditorias formais. Ferramentas de detecção de comportamento anômalo em containers, como agentes que identificam processos suspeitos, conexões estranhas ou acessos fora de horário, já fazem parte do conjunto de melhores ferramentas de segurança para clusters kubernetes em organizações mais exigentes. Um cuidado que muita gente esquece é treinar o time para reconhecer sinais de ataque, documentar playbooks de resposta e, principalmente, testar esses playbooks em exercícios controlados, em vez de descobrir na hora do incidente que ninguém sabe quem decide o quê ou como isolar um namespace problemático.

Passo 7: integrações com cloud provider e serviços de segurança gerenciados

Quando falamos de clusters seguros na nuvem, vale aproveitar o que o próprio provedor oferece para não reinventar a roda. Serviços gerenciados reduzem um pedaço da superfície de ataque, mas também acrescentam novas configurações para cuidar, como a forma de expor load balancers, integrar com KMS para criptografia de segredos e conectar logs a serviços gerenciados de SIEM. Muitos serviços de segurança para kubernetes na nuvem hoje já vêm com recomendações automáticas, painéis de conformidade e até correções guiadas, o que ajuda bastante equipes menores ou em fase inicial de maturidade. Ainda assim, é importante entender limites de responsabilidade compartilhada: o provedor cuida de parte da infraestrutura, mas o desenho de RBAC, policies de rede, imagens e segredos continua sendo obrigação do time que opera o cluster. Ignorar essa fronteira é um dos erros que mais aparecem em análises de pós-incidente.

Ferramentas, treinamento e como sair do zero sem se afogar em opções

No universo de Kubernetes, surgem novas ferramentas de segurança quase todo mês, e é fácil ficar paralisado tentando escolher. Um caminho prático é começar com um baseline: um scanner de configuração de cluster, um scanner de imagem integrado ao CI, um mecanismo de policy admission e um bom stack de observabilidade. Com isso na mão, você já cobre uma parte considerável dos riscos mais comuns. Se o time ainda está se adaptando, vale investir em capacitação estruturada, como um curso online de segurança e hardening em kubernetes que combine teoria com laboratórios de ataque e defesa, em vez de apenas colecionar tutoriais soltos. Para empresas maiores, muitas vezes compensa trazer uma consultoria externa com experiência em ambientes semelhantes ao seu, aquela típica consultoria em hardening de kubernetes para empresas que já tropeçou em vários problemas em outros clientes e consegue antecipar armadilhas antes que elas apareçam no seu cluster.

Alertas de erros comuns e dicas práticas para quem está começando

Alguns tropeços se repetem tanto que vale deixar os avisos bem claros. Deixar o kube-dashboard ou outros painéis administrativos expostos sem autenticação forte continua sendo um clássico que causa dor de cabeça. Outra armadilha é confiar demais em “security by obscurity”, imaginando que um cluster com nome esquisito e portas pouco usuais vai passar despercebido; scanners automatizados não se importam com nomes. Para quem está começando, uma boa dica é criar um ambiente de laboratório o mais parecido possível com a produção, mas com dados sintéticos, e testar ali todas as políticas de segurança antes de empurrar para o ambiente crítico. Também ajuda documentar decisões de segurança: por que tal política foi configurada de determinada forma, que trade-offs foram aceitos, quando será revisitada. Esse hábito aparentemente burocrático torna futuras auditorias mais simples e evita que, em mudanças de equipe, as pessoas desfaçam proteções importantes por falta de contexto sobre a motivação original.

O futuro do hardening em Kubernetes: tendências de 2026 em diante

Olhando para frente, o tema de hardening em Kubernetes tende a ficar cada vez mais automatizado e “shift-left”. Já em 2026 se vê uma movimentação forte em direção a políticas declarativas de segurança, verificadas desde o repositório de código até o runtime, com plataformas que geram relatórios de conformidade praticamente em tempo real. A tendência é que integrações com identidade, assinatura de artefatos e validação de supply chain se tornem parte natural dos pipelines, sem tanta fricção manual. Ao mesmo tempo, a expansão de workloads de IA e serviços de dados sensíveis em clusters aumenta a pressão por isolamento mais refinado, uso mais intenso de criptografia e controles de acesso baseados em contexto. Em paralelo, o mercado se especializa: serviços gerenciados, serviços de segurança e até programas de certificação para operadores de cluster se consolidam. Quem se antecipar, estruturando bem a base de hardening hoje, vai conseguir aproveitar essas evoluções com muito menos correria, ajustando o que já existe em vez de ter que refazer tudo às pressas ao primeiro sinal de nova exigência regulatória ou de uma brecha explorada em grande escala no ecossistema.