Por que gestão de segredos em cloud é tão crítica hoje

A gestão de segredos em cloud deixou de ser “coisa do time de segurança” e virou pré-requisito básico para qualquer aplicação séria. Senhas de banco, tokens de API, certificados, chaves SSH e chaves de criptografia estão em todo lugar, e um vazamento costuma ser rápido, barulhento e caro. Em ambientes multi-cloud, esse risco só aumenta. É aqui que entram Vaults, KMS e a tal integração DevSecOps com vault e kms: você automatiza como gera, armazena, usa e renova segredos, sem depender de ZIPs escondidos, variáveis de ambiente mal pensadas ou arquivos .env jogados no repositório. A boa notícia: com um pouco de disciplina e as ferramentas certas, dá para organizar tudo de forma previsível e auditável.

Passo 1: Entender o papel de Vaults e KMS (sem misturar as bolas)

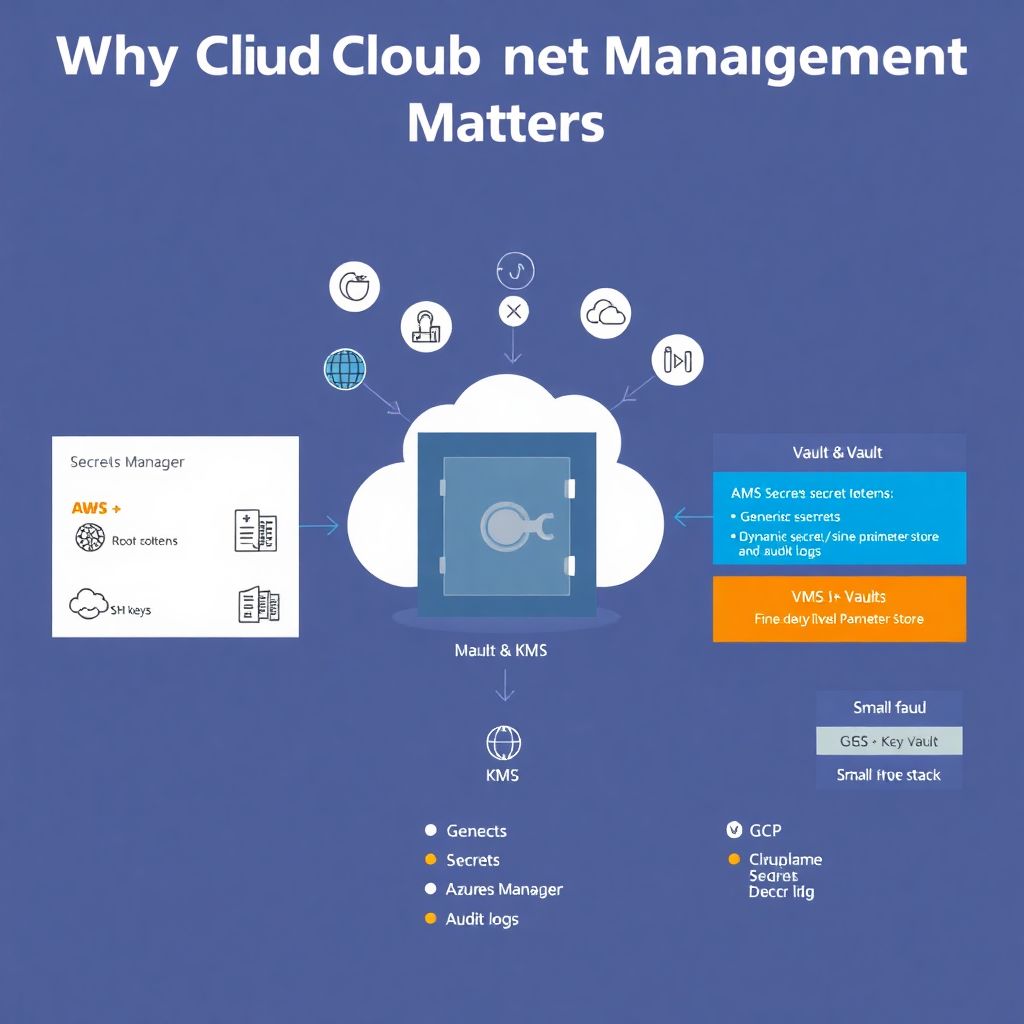

Antes de sair implementando, vale separar conceitos. O KMS (Key Management Service) foi pensado para gerenciar chaves criptográficas usadas para cifrar dados em repouso, assinar tokens e proteger outros segredos indiretamente. Já um Vault (como HashiCorp Vault ou serviços nativos de secrets) é mais generalista: armazena segredos arbitrários, suporta rotação automática, controle fino de acesso e auditoria detalhada. A famosa expressão gestão de segredos em cloud vault kms só faz sentido quando você combina os dois: o KMS cuida da raiz criptográfica e o Vault atua como “cofre de alto nível”, expondo APIs amigáveis para as aplicações, com políticas e workflows integrados.

Passo 2: Escolher o stack certo em cada provedor

Quando falamos de ferramentas de secret management aws azure gcp, o cardápio é grande, mas o princípio é parecido. Na AWS, o combo mais comum é AWS KMS + AWS Secrets Manager ou SSM Parameter Store. Na Azure, Azure Key Vault cobre tanto segredos quanto chaves criptográficas. No GCP, o par clássico é Cloud KMS + Secret Manager. Especialistas costumam recomendar: primeiro, usar o serviço nativo do provedor para ter melhor integração com IAM e logging; depois, se for multi-cloud ou se precisar de features avançadas (como segredos dinâmicos para bancos), considerar um Vault centralizado, como HashiCorp Vault, sentado “por cima” desses serviços nativos, usando o KMS de cada cloud como raiz de confiança.

Passo 3: Planejar o modelo de acesso e privilégios mínimos

Nada de começar criando segredos sem pensar em quem pode acessá-los. O desenho de IAM é tão importante quanto escolher a ferramenta. A recomendação padrão de quem já viu incidente feio é aplicar “least privilege” desde o começo: cada serviço com seu próprio principal (role, managed identity, service account), com acesso apenas ao conjunto mínimo de segredos. Evite o padrão “uma conta de serviço para tudo”, porque isso vira ponto único de comprometimento. Use labels, tags ou naming conventions para separar segredos por ambiente, time e criticidade. E lembre: visualize desde cedo como será o processo de revisão de acessos e revogação, senão o acúmulo de permissões vira bomba-relógio.

Passo 4: Boas práticas de uso do KMS e cuidado com custos

Sobre serviço de key management service kms preço, tem uma armadilha comum: sair criando centenas de chaves sem critério e depois descobrir que rotação, requests de criptografia e políticas geram uma conta maior do que o esperado. A abordagem recomendada é: comece simples, com poucas CMKs/keys principais por domínio de dados (por exemplo: uma por ambiente e tipo de dado sensível) e vá refinando conforme cresce. Ative rotação automática sempre que o serviço oferecer, e separe chaves usadas para dados “em repouso” das usadas para assinar tokens ou criar envelopes para outros segredos. E, crucial: nunca deixe o KMS exposto para uso direto por usuários humanos sem uma camada de política por cima.

Passo 5: Padronizar o fluxo de criação e rotação de segredos

Segredo que não tem dono e não tem ciclo de vida definido acaba esquecido e vazando em log, ticket ou screenshot. Padronize como os times vão criar, atualizar e descartar segredos. Uma prática que especialistas recomendam é ter playbooks claros: quem solicita, quem aprova, onde o segredo nasce (Vault, CLI, pipeline), quanto tempo vive, quando expira e como a aplicação descobre que mudou. Em Vaults mais completos, aproveite segredos dinâmicos (por exemplo, credenciais de banco com TTL curto) para evitar senhas “eternas”. Em clouds nativas, use a API de rotação integrada com Lambdas, Functions ou Cloud Functions. Tudo versionado e auditável, sem “gambiarra manual” no console.

Integração DevSecOps na prática: do commit ao deploy

A integração devsecops com vault e kms é onde teoria encontra realidade. A ideia é simples: nenhum segredo entra no repositório de código; o pipeline só consome segredos diretamente do Vault/KMS ou do serviço de secrets do provedor. Na prática, isso significa configurar os stages do CI/CD para autenticarem usando uma identidade da plataforma (OIDC, IAM Role, Managed Identity) e obterem segredos “on-demand”, com escopo mínimo. Nada de copiar valor para variáveis estáticas em dezenas de pipelines. Assim, quando você rotaciona um segredo, todos os pipelines passam a usar a nova versão automaticamente, sem ter que editar YAML manualmente a cada mudança.

Exemplo de fluxo passo a passo para times iniciantes

1. Mapear todos os segredos usados pela aplicação (banco, APIs externas, chaves JWT).

2. Escolher o serviço nativo de segredos do seu provedor (ou Vault, se for multi-cloud).

3. Migrar manualmente os segredos críticos para o cofre, removendo-os de arquivos .env e configs no repositório.

4. Ajustar a aplicação para buscar segredos em runtime via SDK ou injeção automática do ambiente.

5. Configurar autenticação baseada em identidade (IAM role, service account) em vez de chaves estáticas.

6. Habilitar rotação automática onde possível.

7. Monitorar logs de acesso ao cofre e revisar permissões regularmente, corrigindo excessos.

Atenção aos erros mais comuns (e como evitar cada um)

Alguns padrões de erro se repetem tanto que valem um alerta direto. Primeiro: guardar segredos em variáveis de ambiente sem controle de origem, que depois aparecem em dumps de logs ou ferramentas de observabilidade. Segundo: compartilhar a mesma credencial entre time inteiro “porque é mais prático”, matando qualquer rastreabilidade. Terceiro: não testar rotação na prática; o time ativa rotação automática e descobre, em produção, que a aplicação não sabe lidar com credenciais novas. Especialistas insistem: trate rotação como caso de teste obrigatório. Quarto: ignorar o escopo de chaves KMS e permitir uso irrestrito por qualquer serviço, o que facilita movimentos laterais após um comprometimento inicial.

Dicas para iniciantes: começar pequeno, mas bem feito

Se você está começando agora com melhores práticas segurança de segredos cloud, não tente resolver tudo em uma migração gigantesca. Comece por um serviço mais crítico (por exemplo, o banco de produção) e use esse caso como piloto. Documente o que funcionou, o que quebrou, e converta isso em um “modelo padrão” para os outros times. Simplifique o onboarding: templates de Terraform/CloudFormation/Bicep com módulos prontos, exemplos de código em diferentes linguagens e um guia rápido de “como consumir segredos no seu serviço”. E, principalmente, evite ferramentas exóticas quando os serviços nativos já atendem 90% dos cenários; reduzir complexidade também é uma forma de segurança.

Recomendações finais de especialistas

Profissionais com experiência em incidentes de vazamento costumam reforçar três pontos. Primeiro: logging e auditoria são tão importantes quanto criptografia; de nada adianta um cofre robusto se você não sabe quem abriu a porta. Segundo: alinhe a gestão de segredos com o processo de onboarding/offboarding de times e serviços, senão credenciais antigas continuam válidas por meses. Terceiro: trate gestão de segredos em cloud vault kms como disciplina contínua, não como projeto pontual. Novos serviços, novas integrações e novas stacks surgem o tempo todo; sem revisão periódica e automação, a entropia volta. Segurança de segredos madura é mais sobre processo bem pensado do que sobre ter “a ferramenta da moda”.