Por que segurança em Kubernetes parece сложнее, чем есть на самом деле

Когда люди впервые заходят в мир Kubernetes, им быстро показывают деплойменты, сервисы и магию автоскейлинга. А вот безопасность обычно подвешивают «на потом», как будто это можно прикрутить одной галочкой в конце. Отсюда и вырастают классические истории: кластер с правами admin:admin, открытый в интернет, доступ к dashboard без аутентификации, секреты в конфигмапах, а логи — на публичном S3 без шифрования. В итоге segurança em kubernetes em produção превращается в набор спешных костылей, а не в продуманную архитектуру. Нормальный подход начинается с принятия факта: Kubernetes сам по себе — не продукт, а конструктор, и по умолчанию он скорее удобен, чем безопасен. Именно поэтому так важно строить модель угроз и постепенно усиливать защиту, а не надеяться, что «кластер в managed-сервисе уже достаточно защищён провайдером».

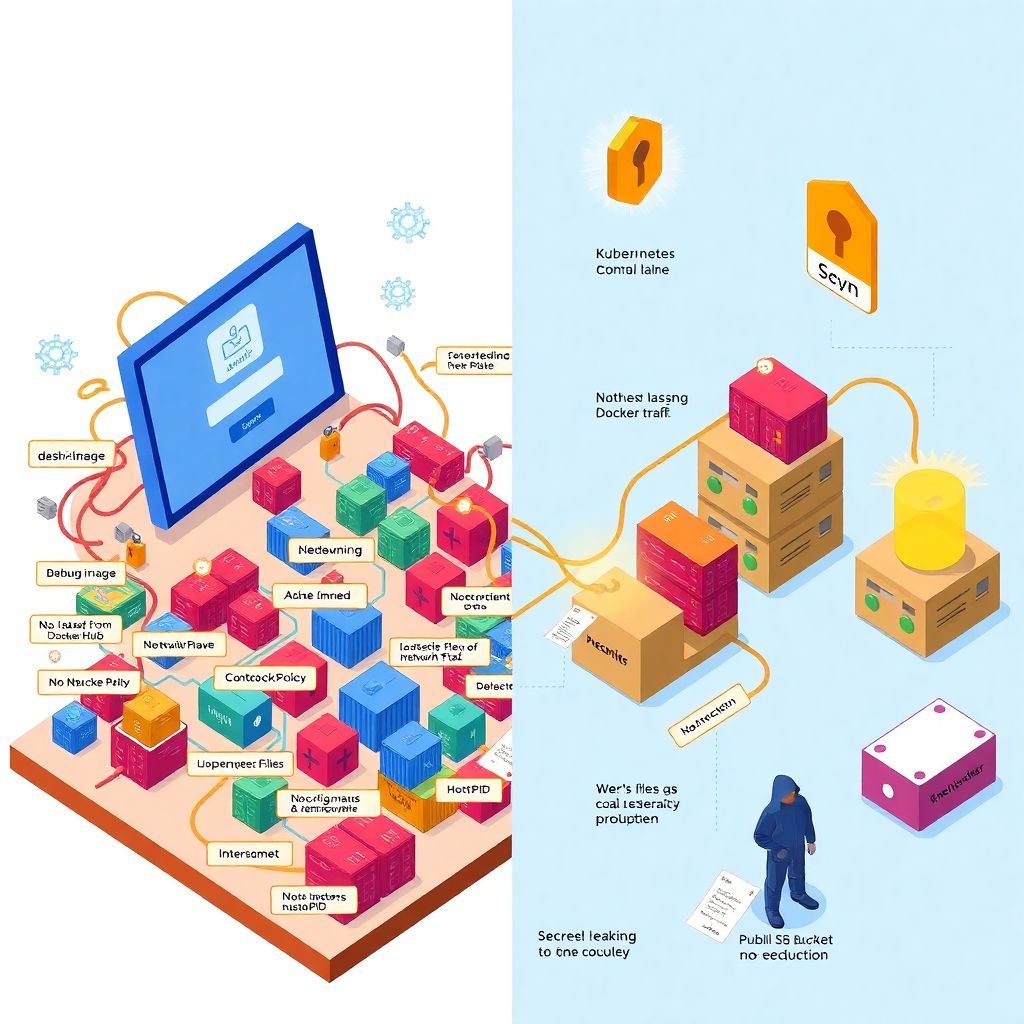

Типичные ошибки новичков: от «работает же» до «почему нас взломали?»

Full admin для всех и вся

Одна из самых частых ошибок начинающих администраторов Kubernetes — полное игнорирование RBAC. Новичок радостно создаёт сервисный аккаунт с cluster-admin, чтобы «ничего не ломалось», а затем этим аккаунтом пользуются CI, разработчики и временами даже внешние утилиты. В security-отчётах это выглядит как «космический корабль с открытым люком», а в реальных кейсах это заканчивалось тем, что скомпрометированный под из dev-namespace мог без проблем читать секреты из production, удалять ноды и менять NetworkPolicy. Ошибка понятна: когда что-то не работает, люди выдают больше прав «на время отладки», а потом забывают убрать. Неочевидное, но полезное правило: если вы не можете объяснить, почему конкретному аккаунту нужны права cluster-admin, значит, они ему не нужны; вместо этого начните с read-only ролей и расширяйте права только по факту необходимости.

Сетевой «оголённый провод» внутри кластера

Многие по привычке думают, что внутренний трафик в кластере «и так безопасен», особенно если это managed Kubernetes у облачного провайдера. В итоге NetworkPolicy не создаются месяцами, а сервисы внутри кластера общаются друг с другом, как в старом плоском датацентре. В одном из реальных инцидентов злоумышленник пробил только один уязвимый pod с дебаг-образом, но смог через него просканировать весь кластер и найти сервис с открытым админским API без авторизации. Если бы стояли минимальные политики «deny by default» между namespace, атака закончилась бы внутри одного микросервиса. Именно поэтому melhores práticas de segurança para clusters kubernetes включают сегментацию по namespace, строгие NetworkPolicy и ограничение egress, чтобы pod не мог просто так стучаться во внешний интернет или во внутренние критичные сервисы без явного разрешения.

Образы как «чёрный ящик» и доверие к чужим Docker Hub

Ещё одна типичная ловушка новичков — полагаться на произвольные публичные образы без сканирования уязвимостей и без контроля версий. Часто берут «latest» с Docker Hub какого-нибудь небольшого проекта, разворачивают в продакшене и искренне надеются, что там всё хорошо. Со временем такой образ может получить новые зависимости, изменения поведения и свежие CVE, а ваш кластер будет верить ему по умолчанию. В real-case историях это выливалось, например, в появление майнеров внутри контейнеров или в использование устаревших OpenSSL без критичных патчей. Вместо этого имеет смысл выстраивать внутренний registry, фиксировать теги по хешу, включить автоматическое сканирование и не запускать ничего, что не прошло проверку политиками admission controller, даже если оно «так удобно и быстро».

От базового кластера к устойчивому продакшену

Hardening на уровне control plane и worker-нод

Когда говорят про hardening kubernetes para ambiente de produção, часто думают только о настройке PodSecurity или ограничении capabilities. Но устойчивость начинается ещё до этого — на уровне операционной системы ноды и самого control plane. Нередко вижу кластеры, где на worker-нодах крутятся вспомогательные сервера, тестовые агенты и даже SSH-доступ для разработчиков «на всякий случай». Это удобный путь к нарушению изоляции между контейнерами и хостом. Неочевидное, но крайне эффективное решение — рассматривать каждую ноду как «чистый appliance»: минимум пакетов, отключённые лишние службы, монтирование файловой системы с ограничениями, запрет прямого SSH и управление только через автоматизированные инструменты. Такой подход снижает поверхность атаки и делает компрометацию отдельной ноды менее катастрофичной для всего кластера.

Контейнеры по принципу «минимум доверия»

По умолчанию многие новички дают контейнерам root-права, полный доступ к файловой системе внутри пода и не ограничивают syscalls. В итоге любой RCE в приложении превращается в удобную точку опоры для дальнейшего движения по кластеру. Реальный кейс: контейнер с Node.js-приложением, запущенный из дебаг-образа, имел кучу лишних пакетов и toolchain, что позволило атакующему быстро собрать дополнительные инструменты прямо внутри пода. Неочевидное улучшение — серьёзно относиться к securityContext: запуск от не-привилегированного пользователя, readOnlyRootFilesystem, минимум capabilities, запрет привилегированных контейнеров. Если добавить поверх этого seccomp и AppArmor/SELinux профили, вы превращаете обычный pod в существенно более стойкую к взлому сущность, даже если в вашем приложении всплывёт уязвимость уровня RCE.

Инструменты и экосистема: как не утонуть в зоопарке решений

Инструменты для enterprise и что из них реально нужно

Когда компания дорастает до крупного масштаба, на горизонте появляются различные ferramentas de segurança para kubernetes enterprise: коммерческие платформы, которые обещают полную видимость, автоматические политики и мгновенные алерты. Они действительно полезны, но новичков часто пугают своей сложностью и ценником. Профессиональный лайфхак: перед тем как покупать большой продукт, выжмите максимум из open-source экосистемы — сочетание сканеров образов, policy engines вроде OPA/Gatekeeper или Kyverno и мониторинга на базе Prometheus/Alertmanager уже покрывает большую часть критичных задач. А когда вы понимаете, какие именно сценарии вам больнее всего даются — только тогда имеет смысл смотреть на enterprise-решения, которые закрывают эти конкретные дырки, а не всё подряд.

Admission controllers как «охранник на входе»

Одно из неочевидных решений для повышения уровня защиты — активно использовать admission controllers не только для валидации схемы, но и для принудительного внедрения политик безопасности. Многие компании годами живут с идеей «мы просто договоримся не делать так», а затем получают pod с hostPID, hostNetwork и привилегированным режимом прямо в проде. Гораздо надёжнее однажды потратить время и описать правила: запрет на привилегированные контейнеры, обязательный указанный ресурсный лимит, использование только образов из доверенного registry. Неочевидный бонус: такие политики дисциплинируют разработчиков, потому что любое отклонение от безопасного шаблона сразу отлавливается при деплое, а не всплывает через полгода на аудитах и инцидентах.

Сетевой уровень и Zero Trust в кластере

Сетевые политики и сервис-меш без фанатизма

Пытаясь понять, como proteger cluster kubernetes na nuvem, многие сразу лезут в сложные сервис-меш решения, надеясь, что они «автоматически сделают Zero Trust». На практике без базовой гигиены это превращается в лишний слой сложности. Куда разумнее начинать с явной сегментации: namespace для разных сред, NetworkPolicy, которые по умолчанию ничего не разрешают, и точечное открытие трафика между сервисами. Когда это уже настроено, можно аккуратно добавлять сервис-меш для mTLS между подами, наблюдаемости и canary-деплоев. Альтернативный путь для менее сложных систем — использовать возможности облачных провайдеров: сетевые ACL, security groups и private endpoints, чтобы защитить критичные сервисы, а Kubernetes-уровень использовать как дополнительный слой, а не как единственный рубеж обороны.

Защита egress и выход во внешний мир

Обычно все озабочены входящим трафиком: ingress-контроллерами, WAF и TLS-certificates. Но внутренний pod, который может свободно ходить в интернет, — это прекрасный инструмент для злоумышленника. В одном из кейсов почтовый микросервис, скомпрометированный через уязвимость в библиотеке, использовался как «прокси» для команд и контроля, потому что он имел полный egress в интернет и никакие алерты не срабатывали. Неочевидное решение — рассматривать egress-политику как равноценную ingress: чётко определять, какие поды могут стучаться во внешний мир, какие — только к конкретным доменам или сервисам, а какие не должны иметь интернет-доступ вообще. В сочетании с логированием DNS-запросов и аномалиями по трафику это превращается в мощный инструмент раннего обнаружения вторжений внутри кластера.

Секреты, конфигурации и доступ к данным

Секреты: от «base64 — это не шифрование» до KMS

Новички часто удивляются, узнав, что Kubernetes Secret в etcd хранится не в «настоящем шифровании», а в base64, если вы не включили соответствующую опцию. В реальных инцидентах это выглядело так: кто-то получал доступ к backup etcd или к снапшоту диска master-ноды, после чего вытаскивал из него все секреты к базе, внешним API и приватным репозиториям. Неочевидное, но обязательное требование для продакшена — включить шифрование секретов на уровне etcd с использованием внешнего KMS или cloud-based key management, а также ограничить, кто вообще может читать Secret через API. Альтернативный путь для особо чувствительных данных — использовать внешние секретные хранилища (Vault, cloud secrets manager) и только проецировать их в кластер при необходимости, избегая хранения особо критичной информации внутри самого Kubernetes.

ConfigMap и «случайные» утечки конфигураций

ConfigMap обычно воспринимают как безобидное место для настроек, но туда очень легко по ошибке положить пароли, токены и ключи, особенно на ранних этапах внедрения, когда процессы ещё не устоялись. Было достаточно много случаев, когда разработчики выкладывали манифесты с ConfigMap в публичный Git-репозиторий, а потом удивлялись, что их внутренний API или база данных внезапно стали использоваться посторонними. Профессиональный лайфхак: внедрите простое правило — любой файл с Kubernetes-манифестами проходит автоматическую проверку на наличие строк, похожих на секреты, до того, как он попадёт в репозиторий. Это не серебряная пуля, но она дешёвая и часто спасает от самых глупых утечек уже на раннем этапе, не мешая при этом разворачиванию и развитию продукта.

Ментальная модель: думать об атаках раньше, чем об удобстве

Threat modeling как часть разработки

Чтобы безопасность не превращалась в бесконечные запреты и тормоза, полезно ещё на стадии проектирования сервисов задаваться вопросами: «Что будет, если этот pod скомпрометируют?», «К каким данным он имеет доступ?», «Сможет ли атакующий двинуться дальше по кластеру?». Новичкам кажется, что это сложная формальность, но на практике это просто честный разговор между разработчиками и операторами. Часто оказывается, что сервису не нужны права на запись в базу, достаточно только чтения; что дебаг-контейнер можно держать только в staging; а доступ к административным API удобно ограничить не только аутентификацией, но и network policy. Такая ментальная привычка со временем приводит к тому, что архитектура по умолчанию получается более устойчивой, даже без героических усилий по «харднингу» на каждом шаге.

Security как удобство для команды, а не только ограничения

Зрелый подход к Kubernetes в продакшене заключается в том, чтобы безопасность делала жизнь команды проще, а не сложнее. Автоматические проверки манифестов в CI, готовые безопасные шаблоны деплойментов, стандартные sidecar’ы для логирования и mTLS, чёткая структура namespace — всё это снижает когнитивную нагрузку и уменьшает количество ошибок новичков. Когда безопасный путь становится самым простым и документированным, люди перестают искать «быстрые, но рискованные обходные пути». В итоге segurança em Kubernetes перестаёт быть экзотической темой для отдельных специалистов и становится естественной частью повседневной работы всей команды, что и нужно для по-настоящему устойчивого, production-ready кластера.