Antes de mais nada, vamos alinhar a ideia: buckets S3, Blob Storage e afins são, na prática, o “disco rígido” público da nuvem. Quando mal configurados, viram vitrine de vazamento de dados; quando bem tratados, são quase aborrecidamente seguros. Este guia é um passo a passo prático, em tom direto, para você sair do “acho que está seguro” para uma configuração sólida, comparando as abordagens de AWS, Azure e Google Cloud sem entrar em jargão desnecessário, mas sem perder profundidade técnica.

—

Entendendo o problema: por que buckets abertos continuam aparecendo nas notícias

Riscos comuns em S3, Blob Storage e equivalentes

A origem da maior parte dos incidentes é surpreendentemente simples: permissões abertas demais. Em S3, é o bucket “public-read” sem querer; no Blob Storage, é o container com acesso anônimo; no Google Cloud Storage, é o “allUsers” ganhando leitura por engano. O padrão ouro hoje é: tudo privado por padrão, exceções extremamente bem controladas. Falhas em criptografia, ausência de logs e falta de revisão periódica completam o cenário. O desafio não é a tecnologia em si, mas a soma de cliques apressados, pressa de liberar uma landing page e falta de processo minimamente disciplinado.

Diferenças de filosofia entre AWS, Azure e Google Cloud

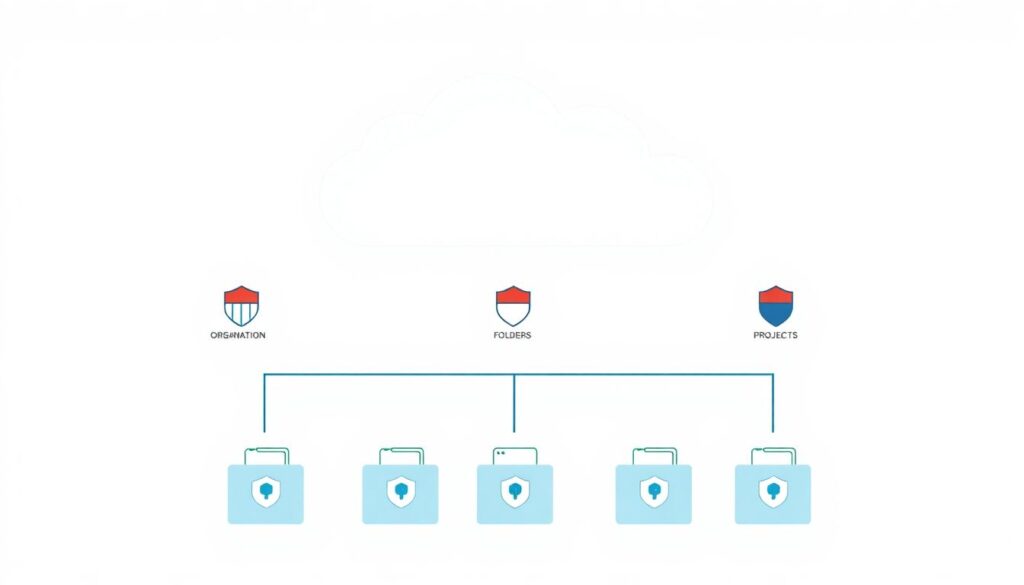

Apesar de todos resolverem o mesmo problema, o jeito de pensar segurança muda. A AWS aposta forte em IAM e políticas JSON extremamente granulares; você monta a “frase” de autorização quase palavra por palavra. A Azure tende a empurrar você para o modelo de identidade corporativa (Azure AD) e RBAC, com papéis pré-definidos; a granularidade está lá, mas escondida atrás de nomes amigáveis. Já o Google Cloud foca em roles bem desenhados por recurso e organização hierárquica (org → folder → project), o que ajuda quando se fala em segurança buckets storage google cloud configuração em larga escala, porém exige que a hierarquia da conta esteja bem planejada.

—

Ferramentas essenciais para uma configuração realmente segura

O que você precisa ter instalado e habilitado

Para caminhar em direção a uma configuração segura s3 aws passo a passo, é útil preparar antes o “kit de ferramentas” local e na nuvem. No lado do desenvolvedor ou do time de DevOps, vale instalar os CLIs oficiais (AWS CLI, Azure CLI, gcloud) e configurar perfis com credenciais de baixa permissão para testes. No lado da nuvem, é indispensável habilitar logs: CloudTrail e S3 Server Access Logging na AWS, Azure Monitor e Storage Analytics, além de Cloud Audit Logs no Google Cloud. Sem telemetria, qualquer tentativa de hardening vira chute educado, sem evidência do que realmente está acontecendo no ambiente de produção.

Utilitários de auditoria e scanners automáticos

Além dos CLIs, entram em cena os scanners de segurança. Na AWS, o Access Analyzer e o Security Hub ajudam a flagrar buckets expostos, enquanto ferramentas open source (como ScoutSuite ou Prowler) analisam configurações de múltiplos provedores. Na Azure, o Defender for Cloud sugere ajustes, inclusive apontando gaps sobre como proteger blob storage azure melhores práticas, cobrindo desde criptografia até políticas de acesso. No Google Cloud, o Security Command Center cumpre papel semelhante, sinalizando buckets compartilhados com o mundo. A junção dessas ferramentas permite sair do modo “checar manualmente” para uma vigilância quase contínua, bem mais resiliente a erros humanos.

—

Modelos de acesso: público, privado e controlado

Acesso totalmente privado: abordagem mais conservadora

Um modelo é radicalizar: todos os buckets e containers privados, sem exceção, e qualquer publicação pública passa por um serviço intermediário (como CloudFront, CDN do Azure ou Cloud CDN). Essa abordagem simplifica a cabeça: você só pensa em segurança na borda, e o armazenamento em si vira zona de confiança máxima, acessada apenas pela aplicação. A desvantagem é a complexidade extra em ambientes pequenos, onde um site estático simples talvez não justifique uma CDN completa. Ainda assim, para dados sensíveis ou empresariais, é a estratégia que mais reduz riscos, especialmente quando se fala em hardening armazenamento em nuvem s3 blob storage de ambientes regulados.

Acesso público controlado: quando e como usar

O outro modelo é aceitar que alguns artefatos precisam ser públicos (imagens estáticas, downloads de marketing, documentação) e, em vez de proibir, controlar bem. Nessa linha, você cria buckets ou containers específicos para conteúdo público, com políticas mínimas necessárias. Em S3, isso significa bloquear ACLs, usar apenas Bucket Policies enxutas e ativar o Public Access Block, liberando apenas o que for realmente inevitável. No Blob Storage, você limita o acesso anônimo a containers específicos e desativa listagem de blobs. No Google Cloud, evita-se o “allUsers” em cima de tudo e usa-se assinaturas temporárias ou CDNs. Aqui o segredo é tratar o armazenamento público como ambiente separado, nunca como padrão fácil para “quebrar um galho”.

—

Passo a passo de configuração segura no S3

Bloqueando acesso público e ajustando políticas IAM

Pensando em configuração segura s3 aws passo a passo, o roteiro básico é: primeiro, ativar o “Block Public Access” em nível de conta e de bucket. Em seguida, garantir que nenhuma ACL conceda acesso a “Everyone”. Depois, definir políticas IAM que usem o princípio do mínimo privilégio, dando a usuários e roles apenas as ações estritamente necessárias (por exemplo, `s3:GetObject` sem `s3:ListBucket` quando cabível). Vale ainda restringir acesso por VPC Endpoint ou IPs corporativos, e, se possível, forçar uso de TLS. Esse modelo reduz drasticamente a chance de exposição acidental em mudanças futuras, porque o controle global barra o famoso “um clique errado no console”.

Criptografia, versionamento e logging no S3

Após fechar as portas, vem o reforço de defesa em camadas. Ative criptografia por padrão, seja com chaves gerenciadas pela AWS (SSE-S3) ou KMS (SSE-KMS) quando houver requisitos de compliance mais rígidos. Em seguida, habilite versionamento para evitar perda de dados em exclusões acidentais ou ataques de ransomware. Por fim, configure o S3 Server Access Logging ou CloudTrail Data Events para registrar quem leu, escreveu ou listou objetos. Esses registros permitem tanto auditoria formal quanto resposta rápida a incidentes, já que você passará a enxergar padrões estranhos de acesso que antes ficariam invisíveis, principalmente em ambientes multi-conta e com vários times mexendo ao mesmo tempo.

—

Protegendo Azure Blob Storage com boas práticas

Controle de acesso com identidades gerenciadas e RBAC

Quando o assunto é como proteger blob storage azure melhores práticas, a Azure incentiva fortemente o uso de identidades gerenciadas e RBAC, em vez de chaves de acesso estáticas. A ideia é atribuir papéis como “Storage Blob Data Reader” ou “Storage Blob Data Contributor” para serviços e usuários específicos via Azure AD, evitando o compartilhamento de secrets em arquivos de configuração. Você também pode limitar o acesso via redes virtuais e regras de firewall, reduzindo a superfície exposta à internet. Outra cautela é revisar periodicamente o acesso anônimo a containers, garantindo que apenas cenários muito bem justificados permitam leitura sem autenticação, e nunca para dados internos ou confidenciais.

SAS tokens, criptografia e monitoramento

Outro componente típico do modelo Azure são os SAS tokens, URLs com permissões e prazos de validade embutidos. Eles são úteis para compartilhamento controlado, desde que você restrinja permissões ao mínimo e use tempos de expiração curtos. Combine isso com criptografia em repouso (que já vem ativada por padrão) e chaves gerenciadas pelo cliente em cenários mais sensíveis. No monitoramento, o Azure Monitor, o Defender for Cloud e os logs de diagnóstico do Storage ajudam a detectar acessos incomuns, fluxos excessivos e configurações inseguras. Essa observabilidade é o que transforma boas intenções em prática operacional consistente ao longo do tempo, não só na hora da implantação inicial.

—

Endurecendo buckets no Google Cloud Storage

IAM por níveis e controle de acesso uniforme

No Google Cloud, a segurança buckets storage google cloud configuração ganha corpo quando você entende a hierarquia: organização, pastas e projetos. Definir boas políticas IAM nesses níveis evita que cada time invente seu próprio padrão, criando um zoológico de permissões. Para os buckets, vale ativar o “Uniform bucket-level access”, que desativa ACLs de objeto e concentra o controle no IAM, diminuindo o risco de exceções caóticas. Papéis como “Storage Object Viewer” e “Storage Object Admin” devem ser concedidos apenas a grupos bem definidos, nunca a “allUsers” ou “allAuthenticatedUsers” de forma ampla. Quando for necessário acesso público, crie buckets separados, com monitoramento extra atento.

Chaves, logs e rótulos para governança

Complementando a parte de IAM, o uso de Customer Managed Encryption Keys (CMEK) via Cloud KMS atende requisitos mais rígidos de auditoria e rotação de chaves. Em paralelo, o Cloud Audit Logs registra acessos administrativos e de dados, permitindo que a equipe de segurança rastreie leituras e alterações relevantes. Por fim, nomear buckets de forma consistente e aplicar labels (projeto, dono, classificação de dados) facilita a governança e a aplicação de políticas automatizadas, inclusive em ferramentas de consultoria segurança cloud configuração buckets s3 blob ou plataformas de CSPM (Cloud Security Posture Management), que dependem de metadados para sugerir e aplicar correções em escala.

—

Comparando abordagens: manual, automatizada e “policy as code”

Configuração manual guiada vs. automação leve

Na prática, você tem três grandes caminhos. O primeiro é a configuração manual guiada por checklists e consoles web. É acessível para times pequenos, mas altamente propensa a erro humano, especialmente quando o ambiente cresce. O segundo é uma automação leve: scripts com CLI, templates com CloudFormation, ARM/Bicep ou Deployment Manager, mais scanners periódicos. Esse modelo reduz erros repetidos e dá certa previsibilidade, mantendo a curva de aprendizado razoável. Em muitos casos, esse meio termo já entrega um nível de hardening armazenamento em nuvem s3 blob storage suficiente para empresas de porte médio, sem exigir uma revolução completa na forma de trabalhar.

Policy as code e integração com pipelines de CI/CD

O terceiro caminho é o mais robusto: tratar políticas de segurança como código, validado e testado junto com a aplicação. Ferramentas como Terraform, Open Policy Agent, AWS Config, Azure Policy e org policies do Google Cloud permitem descrever o que é aceitável ou não em termos de configuração. Pipelines de CI/CD então bloqueiam merges ou deploys que violam essas regras. É um investimento inicial mais alto em automação e cultura, porém paga dividendos na redução de incidentes e no ganho de previsibilidade. Em ambientes multicloud, esse modelo facilita manter padrões consistentes entre S3, Blob Storage e GCS, em vez de depender da memória ou do humor de quem está operando no dia.

—

Troubleshooting: lidando com problemas típicos

Quando o bucket “some” ou a aplicação perde acesso

Um efeito colateral clássico de endurecer segurança é quebrar coisas em produção. De repente, sua aplicação não consegue mais ler ou escrever, mesmo “sem ninguém ter mexido em nada”. O processo de troubleshooting começa pelo básico: checar logs de acesso e mensagens de erro específicas. Em seguida, revisar permissões concedidas a roles, service principals ou service accounts, verificando se alguma política global nova restringiu o que antes era liberado. Em S3, vale conferir o Public Access Block e a combinação de políticas; na Azure, os roles de RBAC e chaves de acesso; no Google Cloud, o IAM e o Uniform bucket-level access, que pode ter mudado o modelo de permissão sem atualização correspondente no código.

Detecção e correção de exposição pública acidental

Outra dor recorrente é descobrir que um bucket ou container ficou público sem intenção. Aqui, a primeira ação é assumir postura de incidente de segurança: identificar quais dados foram potencialmente expostos, restringir acesso imediatamente e revisar logs para entender o alcance do problema. Em paralelo, use os scanners nativos dos provedores e soluções de terceiros para varrer todo o ambiente em busca de configurações semelhantes. Depois de corrigir o caso específico, transforme o aprendizado em política e automação: crie “guard rails” que bloqueiam configurações perigosas na origem, reduzindo a dependência em auditorias manuais esporádicas e aumentando a chance de que o problema não se repita na próxima sprint apertada.

—

Quando faz sentido chamar especialistas externos

Valor de uma consultoria focada em segurança cloud

Nem todo time tem tempo ou experiência para desenhar e manter uma estratégia completa de segurança de armazenamento em nuvem. É aqui que uma consultoria segurança cloud configuração buckets s3 blob pode fazer diferença real. Especialistas externos trazem não só conhecimento técnico, mas também repertório de incidentes de outros clientes, ajudando a antecipar problemas. Eles costumam mapear rapidamente os pontos mais frágeis, propor padrões de naming, segmentação de contas e projetos, além de automatizar políticas mínimas para evitar exposições simples. Essa visão de fora é especialmente útil em ambientes legados, cheios de exceções históricas que ninguém mais lembra por que existem.

Caminho sustentável: aprendizado interno mais parceria

O ideal, no entanto, não é terceirizar completamente a responsabilidade, mas combinar apoio externo com capacitação interna. Enquanto a consultoria desenha a arquitetura, configura as primeiras políticas e implementa ferramentas de monitoramento, seu time participa ativamente, entendendo o porquê de cada decisão. Aos poucos, a equipe assume o dia a dia, usando os especialistas apenas em revisões periódicas ou projetos mais complexos. Esse arranjo garante que o conhecimento não desapareça quando o contrato termina e que a cultura de segurança se torne parte orgânica da rotina de desenvolvimento, operação e governança, em vez de um pacote caro de recomendações que vira PDF esquecido na intranet.