Почему защита API в cloud-native стала критически важной

За последние три года API превратились из “внутреннего транспорта данных” в основной периметр безопасности. Gartner ещё в 2022 году прогнозировал, что к 2025 году API станут самым частым вектором атак, и этот прогноз уже подтвердился: по данным Verizon DBIR 2023–2025, доля инцидентов, напрямую связанных с API, стабильно растёт и в отдельных отраслях переваливает за 50%. Параллельно в отчётах Salt Security за 2023 и 2024 годы более 90% компаний сообщили хотя бы об одном инциденте, связанном с API, а число уязвимых публичных endpoints выросло в разы, особенно в облачных и микросервисных архитектурах.

Краткая историческая справка: от SOAP к cloud-native

Первые массовые интеграции строились вокруг SOAP и ESB, где безопасность опиралась на тяжёлые XML‑шлюзы и централизованные политики. С появлением REST, JSON и мобильных клиентов дизайн стал легче, но логика безопасности часто оставалась прежней: perimeter firewall плюс базовый API key. Когда в 2018–2020 годах начали доминировать Kubernetes и serverless‑подход, монолитные шины интеграции не поспевали за скоростью релизов. В результате segurança de APIs em cloud native стала отдельной дисциплиной, а сами API‑шлюзы и сервисные mesh‑решения эволюционировали в полноценный “контрольный слой” для распределённых приложений.

Базовые принципы: от идентичности до контекста

Защита API в облачной среде строится вокруг трёх столпов: строгая идентификация вызова, проверка прав и управление нагрузкой. Современные решения de autenticação e autorização para APIs опираются на стандарты OAuth 2.1 и OpenID Connect, декомпозируя понятия пользователя, клиента и сервиса. Вместо старого подхода “есть токен — значит, всё можно” применяется контекстная авторизация: учитываются ip‑репутация, тип устройства, гео и риск‑сигналы. Дополняют картину mTLS между сервисами и сегментация на уровне сети и namespace, что особенно важно в мульти‑кластерах Kubernetes и гибридных облаках.

Аутентификация: кто именно вызывает ваш API

В cloud‑native‑окружении аутентификация — это не просто login пользователя, а единый слой идентичности для людей, машин и сервисов. Публичные клиенты используют OAuth с PKCE и короткоживущими access tokens, бэкенды и микросервисы аутентифицируют друг друга через mTLS или JWT, выпущенные централизованным Identity Provider. В отчётах за 2023–2025 годы заметен тренд: доля утечек из‑за украденных статических ключей и паролей сервис‑аккаунтов падает там, где внедрены токены “по требованию” и автоматическая ротация. При этом атаки активно смещаются к эксплуатации ошибок в валидации токенов и неправильной конфигурации провайдеров.

Авторизация: что именно разрешено делать

Когда личность установлена, встаёт вопрос, что именно можно делать с конкретным endpoint. Современная авторизация в API уходит от разрозненных if‑ов в коде к централизованным политикам, описанным декларативно. Всё чаще применяются policy engines вроде OPA или Cedar, подключённые к API gateway и сервисному mesh. Это позволяет внятно разделять уровни: coarse‑grained разрешения на уровне маршрута и метода и fine‑grained правила на уровне ресурсов и атрибутов. С 2023 года крупные финтех‑ и health‑платформы сообщают о снижении серьёзных инцидентов авторизации после перехода на явные, тестируемые политики вместо “скрытой логики” в контроллерах.

Rate limiting и управление трафиком

Rate limiting — это не только про защиту от DDoS, но и про контроль бизнес‑рисков. В облаке нагрузки скачут непредсказуемо: маркетинговая акция либо баг в клиенте могут породить лавину запросов. Именно поэтому платформы de API gateway com rate limiting стали стандартом в cloud‑native: они применяют квоты и лимиты уже на краю, до попадания трафика в кластеры. Начиная с 2023 года крупные SaaS‑провайдеры всё чаще публикуют прозрачные SLO по latency и error rate, а лимиты запросов привязывают к тарифам. Это снижает как эксплуатационные инциденты, так и вероятность успешной bruteforce‑атаки.

Практические стратегии для лимитов и квот

Технически лимиты обычно строятся на токен‑бакетах и скользящих окнах, но ключевой вопрос — где их применять. В cloud‑native‑парадигме лимитируют не только по IP, но и по клиентскому идентификатору, пользователю, организации и даже типу операции. Отчёты Cloudflare и Akamai за 2023–2025 годы показывают, что до 30–40% нежелательного трафика удаётся отсечь именно за счёт поведенческих лимитов, а не только сигнатур. Внутри кластеров роль rate limiting всё чаще берёт на себя сервисный mesh, разгружая приложения от сетевой логики и выравнивая политику между team‑ами.

Как защищать публичные API в облаке

Когда сервис открывается наружу, вопрос como proteger APIs públicas em ambiente cloud выходит на первый план. Одних сетевых фильтров уже недостаточно: нужен связанный набор политик, закрывающих идентичность, данные и поведение. Публичные endpoints прокидываются через API gateway с обязательной аутентификацией, проверкой схемы запросов, ограничением методов и строгим CORS. Дополнительно применяется WAF с правилами, заточенными под OWASP API Security Top 10, и специализированные средства обнаружения аномалий. По данным отраслевых обзоров за 2024–2025 годы, компании, внедрившие многоуровневую защиту публичных API, фиксируют до 50% меньше успешных атак по сравнению с теми, кто полагается только на базовый gateway.

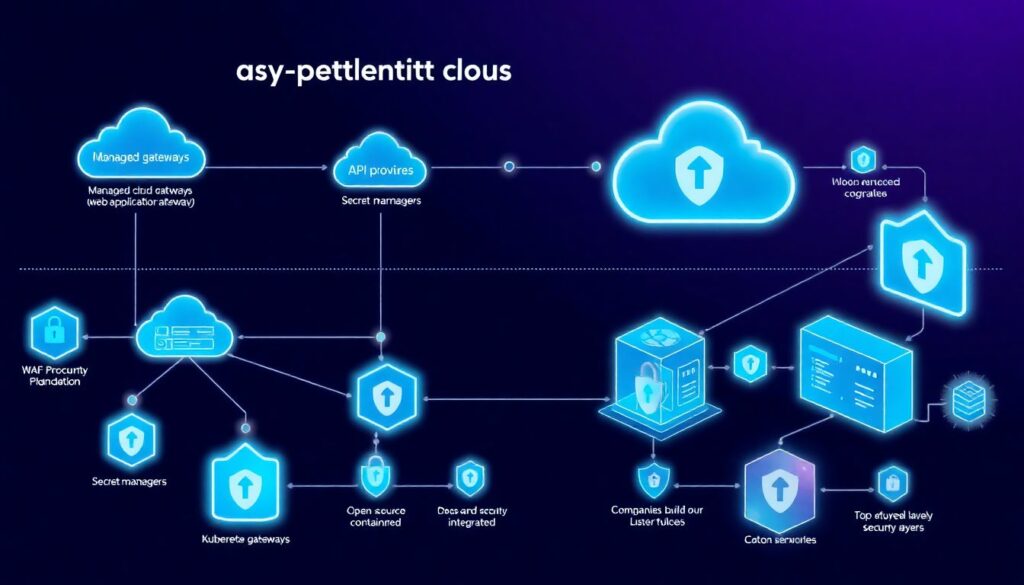

Инструменты и экосистема в cloud-native среде

Сегодня существует широкий спектр ferramentas de proteção de API na nuvem, от управляемых облачных шлюзов до open‑source решений, тесно интегрированных с Kubernetes. Облачные провайдеры предлагают managed‑gateway, WAF, секрет‑менеджеры и сервисы обнаружения аномалий, а поверх них компании строят собственные pipeline‑ы для “security as code”. Начиная с 2023 года растёт интерес к API‑Security‑платформам, которые сканируют спецификации, реальный трафик и инфраструктуру, находя “теневые” endpoints и несогласованные схемы. Это особенно важно в распределённых командах, где API порой появляются быстрее, чем успевают обновиться внутренние каталоги и документация.

Частые заблуждения и опасные мифы

Одно из самых стойких заблуждений — что изоляция в Kubernetes и приватные сети автоматически закрывают все риски. Статистика инцидентов за 2023–2025 годы показывает обратное: большинство критичных утечек через API происходят из‑за логических ошибок и избыточных прав, а не из‑за “дыр” на сетевом уровне. Другой популярный миф — что достаточно одного WAF или gateway, чтобы “решить безопасность”. На практике segurança de APIs em cloud native требует постоянного контроля версий схем, тестирования негативных сценариев, обзора логов и пересмотра политик, иначе даже самый продвинутый шлюз будет просто дорогим прокси.

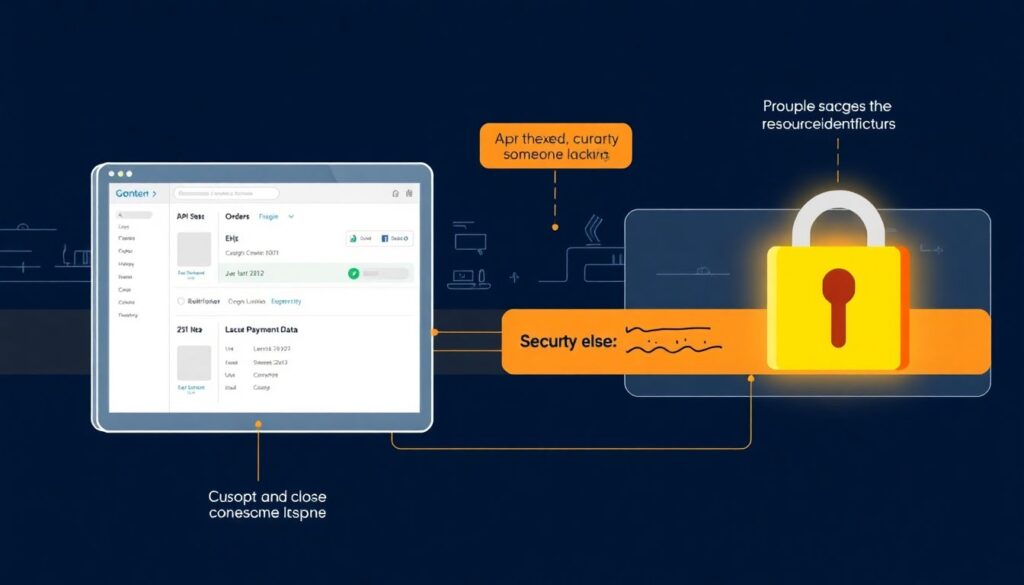

Реальные примеры и уроки последних лет

За три последних года несколько громких инцидентов наглядно показали цену ошибок. У крупных финтех‑и маркетплейс‑платформ проблемы с авторизацией в API позволяли получать чужие заказы и платёжные данные, причём часто без какого‑либо взлома инфраструктуры: достаточно было изменить идентификатор ресурса в запросе. Анализ этих случаев показывает общий паттерн: неявная логика прав, отсутствие негативных тестов и слабый мониторинг. Там, где внедрили централизованные политики доступа, ревью схем и обязательное логирование всех критичных операций, повторные инциденты заметно снизились уже в течение года, подтверждая эффективность системного подхода.