Panorama geral: por que todo mundo fala de falhas em nuvem agora

Quando você lê uma manchete sobre “falhas recentes em provedores de nuvem”, quase nunca é só culpa da AWS, Azure ou Google Cloud “caírem do nada”. Na prática, a maioria dos grandes incidentes mistura três fatores bem humanos: configurações mal feitas, falta de visibilidade e respostas lentas a alertas que já existiam. A boa notícia é que, entendendo como esses problemas aparecem na vida real, dá para transformar cada desastre alheio em um roteiro de prevenção para o seu ambiente. Este guia faz exatamente isso: disseca casos concretos, mostra as raízes técnicas e traduz essas lições em passos práticos para equipes de segurança, inclusive iniciantes em cloud security.

Passo 1. Entender o novo cenário de risco em cloud

Antes de mergulhar em cases, vale alinhar o contexto. A nuvem não é, por si só, mais insegura do que o data center tradicional. O ponto é que o modelo de responsabilidade muda: o provedor cuida da infraestrutura física e parte da camada lógica, mas a superfície de ataque expande brutalmente com APIs, serviços gerenciados, identidades, chaves, pipelines CI/CD e integrações de terceiros. Isso faz com que incidentes de segurança em cloud computing 2024 sejam cada vez menos “ataques exóticos” e cada vez mais resultado de erros de configuração banais em recursos críticos, como buckets de storage, bancos gerenciados e contas de serviço com privilégios amplos.

Erro clássico para novatos: confiar demais no “padrão seguro”

Muita equipe iniciante assume que o “default” da plataforma é automaticamente o mais seguro. Só que defaults são pensados para funcionar fácil, não para ficar blindados. Exemplo: permissões amplas em roles genéricas, regras de firewall internas permissivas ou logging básico sem detalhamento de auditoria. Se você está começando, parta do princípio oposto: nada é seguro até ser revisado. Leia a documentação de cada serviço crítico com foco em seção de segurança, não apenas em “getting started”.

Passo 2. Casos de vazamento de dados por configuração errada

Um dos padrões mais repetidos nas falhas recentes em provedores de nuvem é a exposição acidental de dados sensíveis por configuração equivocada de storage. Tecnicamente não é um “bug” do provedor, mas do uso. Para o atacante, porém, pouco importa: a superfície está aberta, ele explora e pronto. Vários scans automatizados varrem a internet só para achar buckets, blobs ou objetos com políticas permissivas. Assim, um deslize pequeno em uma política de acesso se transforma em vazamento massivo em questão de minutos, sem nem precisar de exploração sofisticada.

Case 1: buckets expostos e o déjà-vu do mundo S3-like

O caso da Capital One em 2019 ficou famoso, mas cenários parecidos seguem acontecendo até hoje em múltiplas clouds. Em vários incidentes mais recentes, empresas descobriram que seus buckets de armazenamento estavam listáveis publicamente ou acessíveis por qualquer usuário autenticado na plataforma, porque alguém aplicou uma policy genérica “*” em um momento de pressa. Na prática, o invasor costuma rodar scanners que testam combinações de nomes de buckets, analisam respostas HTTP e, ao achar algo acessível, faz download de tudo. A repetição desse padrão mostra que como evitar vulnerabilidades em provedores de nuvem passa obrigatoriamente por processos de revisão de políticas, não só por ferramentas.

O que aprender com isso (especialmente se você é iniciante)

Para times mais novos, uma disciplina simples já corta vários riscos: nunca criar storage sem tags e sem revisão de política por outra pessoa. Use policy-as-code (por exemplo, com Terraform + módulos revisados) em vez de configurar permissões via console manualmente. Ative automaticamente scanners internos que checam exposures públicos de buckets e alertam em tempo quase real. E, principalmente, trate qualquer configuração “temporária para teste” como se fosse permanente, porque quase sempre ela acaba virando produção sem ninguém perceber.

Passo 3. Incidentes recentes com terceiros: o caso Snowflake e cadeias de acesso

Um dos exemplos mais discutidos em 2024 foi a série de ataques envolvendo ambientes Snowflake, que atingiram empresas grandes em setores como finanças, varejo e tecnologia. Embora Snowflake não seja um “hiperescala provedor IaaS” como AWS ou Azure, o caso ilustra muito bem como provedores de dados em nuvem entram no seu mapa de risco. Em muitos relatos públicos, o vetor envolveu credenciais comprometidas de clientes (ou parceiros), MFA ausente ou mal aplicado, e falta de monitoramento robusto de acessos atípicos a data warehouses.

Lesson learned: a nuvem do parceiro também é superfície de ataque

Muitas empresas tinham a segurança interna relativamente madura, mas davam por garantido que o provedor de analytics ou data warehouse gerenciado “cuidaria da segurança”. O resultado: chaves de serviço long-lived, usuários sem MFA, IP allowlist relaxada e quase nenhum alerta para padrões de exportação anormais. Isso mostra que gestão de riscos e incidentes em cloud para empresas precisa levar em conta a cadeia de fornecedores SaaS/PaaS, não apenas a conta principal em AWS/Azure/GCP. Políticas de terceiros, due diligence e exigência de logs de auditoria exportáveis tornam-se parte da estratégia, não detalhe contratual.

Dica prática: trate provedores de dados como ambientes internos críticos

Crie processos que obriguem qualquer novo provedor em nuvem a seguir requisitos mínimos: MFA forte para todos os usuários, suporte a SSO/SAML, logs detalhados encaminhados ao seu SIEM, capacidade de configurar RBAC granular e geofencing de acessos. Para times iniciantes, vale montar um checklist padronizado e usá-lo sempre que um time de negócios quiser contratar uma nova solução “cloud-based”. Isso evita aprovações impulsivas que mais tarde se tornam dores de cabeça para o time de segurança.

Passo 4. Incidentes em identidade e e-mail: o caso Microsoft e campanhas persistentes

Outro conjunto de incidentes amplamente discutidos entre 2023 e 2024 envolveu ataques avançados a ambientes Microsoft, incluindo Azure AD (hoje Entra ID) e serviços de e-mail corporativo. Grupos de ameaça sofisticados exploraram combinação de phishing dirigido, falhas de configuração em identidades, erros na rotação de chaves e, em alguns casos, vulnerabilidades em componentes de autenticação para atingir contas de alto valor, como executivos e times de governo. Para muitas organizações, o ponto fraco não era o produto em si, mas a superfície enorme de identidades e permissões, mal governada.

O que isso expõe sobre a maturidade de identidade em nuvem

Em vários relatos oficiais, percebe-se que a ausência de políticas estritas de least privilege, o uso de contas com privilégios elevados para tarefas rotineiras e a falta de monitoramento de login de contas sensíveis facilitaram o movimento lateral dos atacantes. Além disso, muitos ambientes ainda rodavam sem MFA obrigatório para todas as identidades humanas e de máquina, ou com exceções generosas em nome de “conveniência”. Esses incidentes deixam claro que melhores práticas de segurança para ambientes em nuvem começam por um IAM sólido, e não por appliances complexos.

Primeiros passos para times que ainda estão arrumando a casa

Se a sua equipe ainda está no início da jornada de cloud security, ataque o básico com urgência: aplique MFA obrigatória para todas as contas, elimine usuários locais legados quando possível, reduza o número de administradores globais e crie roles específicas para tarefas do dia a dia. Habilite alertas para logins improváveis (novos países, horários fora do padrão, dispositivos não conhecidos) e integre tudo ao seu SIEM. Documente também um playbook rápido para conta comprometida em nuvem: quem aciona, o que bloquear na hora, o que revogar e como notificar áreas impactadas.

Passo 5. Falhas de disponibilidade e impacto operacional

Nem todo incidente é sobre vazamento de dados; indisponibilidade também é um problema crítico. Grandes provedores já tiveram outages regionais que derrubaram centenas de serviços dependentes em cascata. Em vários episódios, um erro de configuração interna, atualização mal sucedida ou falha em componentes de rede e controle gerou interrupções de horas. Para equipes que acreditavam que “estar na nuvem” automaticamente garante alta disponibilidade, o choque é grande quando uma região inteira fica instável ou quando dependências globais como DNS interno e filas de mensagens falham ao mesmo tempo.

Erro comum: projetar sistemas como se só o data center próprio falhasse

Muitos arquitetos migraram workloads para cloud mantendo mentalidade de data center: dependência de uma única região, ausência de replicação multi-region, falta de teste de failover e planos de continuidade limitados. Quando o provedor tem um incidente mais amplo, essas aplicações simplesmente param, sem opção rápida de recuperação. Isso mostra que como evitar vulnerabilidades em provedores de nuvem não se limita a segurança de confidencialidade e integridade; inclui também desenhar resiliência contra falhas operacionais do próprio provedor.

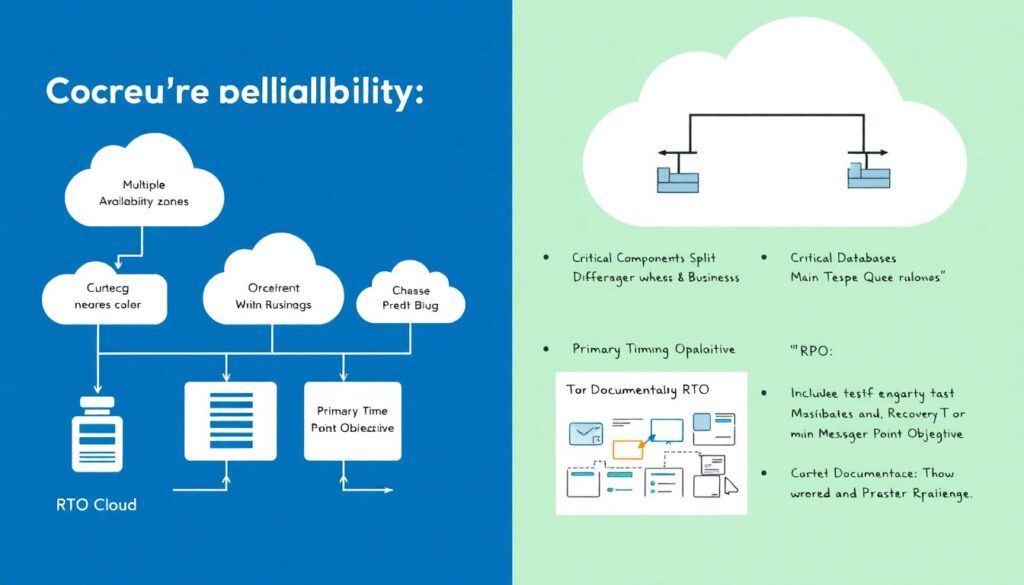

Recomendações práticas para disponibilidade em ambientes cloud

Mesmo para equipes menores, vale investir em alguns princípios básicos: use múltiplas zonas de disponibilidade, separe componentes críticos em regiões diferentes quando o negócio permitir, e teste cenários de desligamento de serviços de base (como banco primário ou fila principal). Documente RTO/RPO e verifique se a arquitetura realmente os atende. Para novatos, começar com um exercício simples de “game day” — simular a queda de um serviço gerenciado e observar o comportamento do sistema — geralmente revela lacunas que diagramas não mostram.

Passo 6. Padrões recorrentes de erro em times de segurança

Olhando de forma transversal para incidentes grandes ou pequenos, alguns padrões se repetem nas equipes responsáveis pela defesa. As principais falhas estão menos em “não ter a ferramenta correta” e mais em lacunas de processo, cultura e priorização. Ferramentas de CSPM, SIEM, DLP e afins só funcionam se forem alimentadas, calibradas e realmente usadas para tomada de decisão diária. Sem isso, viram apenas dashboards bonitos e alarmes ignorados.

Cinco erros frequentes (e como evitá-los)

1. Tratar nuvem como um datacenter remoto.

Ignorar conceitos como identidade como perímetro, APIs, automação e ephemeral infrastructure leva a copiar controles on-prem que não escalam e não se encaixam.

2. Subestimar a complexidade de IAM.

Roles genéricas, permissões “temporárias” e contas de serviço superpoderosas acabam abrindo portas gigantes. Use least privilege desde o início, mesmo que dê mais trabalho.

3. Falta de visibilidade centralizada.

Logs espalhados, sem correlação em um SIEM, dificultam detectar movimentos laterais e acessos anômalos. Priorize ingestão e normalização de logs de auditoria e rede.

4. Dependência excessiva de configuração manual.

Sem infra-as-code, cada mudança é uma chance de erro humano. Adote templates revisados, revisão por pares e pipelines com validação de segurança.

5. Ausência de treino de resposta a incidentes.

Muitos times só descobrem se o playbook funciona durante o incidente real. Faça exercícios periódicos, com cenários baseados em incidentes de segurança em cloud computing 2024 e anteriores.

Alerta para iniciantes: não tente “abraçar a nuvem inteira” de uma vez

Uma armadilha comum para quem está começando é tentar cobrir todos os serviços e todas as regiões logo de cara, criando dezenas de políticas meia-boca. Foque primeiro em ativos mais críticos: identidades privilegiadas, storage com dados sensíveis, bancos de produção e endpoints expostos à internet. Defina um baseline sólido para esses pontos e vá ampliando a cobertura conforme ganha experiência. A profundidade em áreas-chave vale mais do que uma superfície “coberta” superficialmente.

Passo 7. Boas práticas para fortalecer sua postura de segurança

Depois de aprender com casos reais, a pergunta natural é: o que implementar na prática, passo a passo? A base está na combinação de arquitetura, processos e automação. Não basta só “melhores ferramentas”; é necessário um conjunto articulado de controles que funcionem em conjunto e sejam revisados regularmente. Abaixo, um roteiro de adoção progressiva que pode ser adaptado tanto para empresas pequenas quanto para corporações maiores.

Roteiro em 7 passos para endurecer a segurança em nuvem

1. Mapear o inventário de ativos em nuvem.

Use as ferramentas nativas dos provedores e soluções de descoberta para identificar contas, projetos, recursos expostos, bancos, buckets e identidades. Sem inventário, qualquer plano é chute.

2. Estabelecer um baseline de configuração segura.

Aplique benchmarks (como CIS) adaptados à sua realidade, definindo padrões mínimos para logging, criptografia, redes, IAM e storage. Use policy-as-code para reforçar o baseline.

3. Fortalecer IAM e MFA.

Revise todas as contas privilegiadas, reduza o escopo de permissões e imponha MFA forte. Para contas de serviço, use roles específicas, rotação automática de chaves e acesso just-in-time quando possível.

4. Blindar dados sensíveis.

Classifique dados e aplique criptografia gerenciada com KMS, políticas de acesso detalhadas e monitoramento contínuo de buckets e bancos expostos. Automatize alertas de exposição pública.

5. Centralizar logs e monitoramento.

Envie logs de auditoria, autenticação, rede e serviços para um SIEM. Configure detecções específicas de anomalias em nuvem, como uso de tokens fora de padrão, acessos de origens improváveis e escalonamento de privilégios.

6. Automatizar segurança em pipelines CI/CD.

Inclua scanners de IaC, análise de dependências e checagens de política em cada build. Bloqueie deploys que violem o baseline de segurança ou criem recursos críticos inseguros.

7. Exercitar resposta a incidentes com base em casos reais.

Simule cenários inspirados em falhas recentes, como vazamento de bucket, credencial exposta em repositório público ou sequestro de conta privilegiada. Atualize o runbook após cada exercício.

Como adaptar esse roteiro à realidade da sua empresa

Empresas menores podem priorizar itens 1 a 4, usando ao máximo recursos nativos dos provedores, enquanto organizações maiores ganham muito ao investir pesado em monitoramento avançado, automação e integração entre times (SecOps, DevOps, DataOps). Independentemente do porte, é essencial que a gestão de riscos e incidentes em cloud para empresas seja tratada como disciplina contínua, com métricas, revisões periódicas e patrocínio executivo, e não apenas como projeto pontual após um susto.

Passo 8. Conclusão: transformar notícias ruins em vantagem estratégica

Cada novo incidente público — seja um vazamento por storage exposto, um comprometimento de identidades ou uma falha de disponibilidade em larga escala — é uma oportunidade gratuita de aprendizado. Em vez de apenas “culpar o provedor”, times de segurança maduros usam essas histórias como insumo para revisitar seus próprios controles, ajustar arquiteturas e fortalecer processos. A nuvem continuará evoluindo, assim como os atacantes; a diferença entre quem sofre o próximo grande incidente e quem passa relativamente ileso costuma estar na disciplina de revisar continuamente configurações, automatizar boas práticas e testar, na prática, se o plano de resposta realmente funciona. Para equipes de segurança, especialmente as que estão começando, a chave é simples: observar com atenção, aprender sem vaidade e aplicar de forma incremental, sempre lembrando que cada falha pública é um espelho potencial do seu próprio ambiente.