Por que buckets e storages cloud ainda vazam dados em 2026

Cloud storage já não é novidade, mas o número de incidentes continua alto. Buckets S3 abertos, blobs públicos “sem querer”, snapshots com dados sensíveis expostos… a lista é longa. Em 2026, o problema raramente é falha da nuvem; quase sempre é configuração ruim, pressa ou falta de governança.

Quando falamos em segurança em storage cloud como evitar vulnerabilidades, o foco tem que sair do “marcar checkbox” e ir para desenho de arquitetura, automação e revisão contínua. O objetivo desta matéria é justamente sair do óbvio (“não deixe bucket público”) e entrar no que realmente pega na prática, com casos reais, soluções não triviais, alternativas e alguns hacks de gente experiente.

—

Vulnerabilidades mais comuns em buckets e storages cloud

1. Buckets “quase” privados (mas indexáveis)

Uma das armadilhas mais frequentes: o bucket não está 100% público, mas está configurado de forma que algum caminho ainda vaza. Exemplo clássico no S3: bloquear listagem anônima, mas permitir `GetObject` por ACL ou política mal escrita.

Esse tipo de erro é comum quando times misturam ACLs legadas, políticas de bucket, políticas de IAM e configurações de acesso público globais. Em Azure e GCP, o problema aparece quando se permite acesso público “só para este container” para um teste, e isso nunca é revertido.

Padrões típicos de falha:

– Regras “Allow *” em condições muito amplas

– Herança de permissões de um template antigo “temporário”

– URLs de acesso direto expostas em código cliente ou front-end

Curiosidade dolorosa: há bots que fazem crawling contínuo por buckets e domínios conhecidos, testando variações de nomes e caminhos previsíveis. Não é alguém “te caçando”; é só mais um scanner rodando 24×7.

—

2. Buckets públicos por design, sem controles em volta

Alguns buckets precisam ser públicos: sites estáticos, assets de front-end, downloads públicos de clients etc. O problema não é ter buckets públicos, e sim não isolar o que é público do que é sensível.

A falha clássica: usar o mesmo storage account / projeto / naming convention para conteúdo público e privado. Em uma migração, alguém “racionaliza” as políticas, unifica padrões… e acaba abrindo mais do que deveria. A pergunta certa não é “como proteger buckets públicos na nuvem evitar vazamento de dados removendo o público”, e sim: como limitar o impacto de um bucket público inevitável.

Algumas medidas simples que mudam o jogo:

– Nunca misturar dados sensíveis e assets públicos no mesmo storage logical boundary

– Endpoints públicos dedicados, com domínios separados e bem identificados

– Monitoramento específico para acessos e objetos inesperados em buckets de conteúdo público

—

3. Chaves de acesso e tokens embedados em código

Outro vetor recorrente: o bucket em si está ok, mas as credenciais da aplicação estão expostas. Código no GitHub, .env comprometido, pipeline vazado. Resultado: atacante com acesso programático pleno a buckets “privados”.

Mesmo com IAM moderno, ainda se vê:

– Access keys hard-coded em front-end (SPA) ou mobile apps

– Tokens gerados com permissões amplas e validade excessiva

– Perfis de serviço compartilhados entre apps com escopos muito diferentes

A configuração segura de storage cloud para dados sensíveis começa, na prática, pela higiene de credenciais da aplicação e dos pipelines de CI/CD, não apenas pelo checkbox de “block public access”.

—

4. Logs e backups: o “lixão” que todo mundo esquece

Logs de acesso, versões antigas de objetos, dumps de banco colocados “rapidinho” em um bucket qualquer: tudo isso costuma cair num storage menos controlado, que vira um alvo atraente.

Histórias reais de incidentes mostram:

– Dumps de produção em buckets de teste, para “agilizar”

– Snapshots de discos com chaves, tokens e configs sensíveis, copiados para cold storage sem criptografia gerenciada

– Logs de acesso contendo tokens de sessão ou dados pessoais, armazenados em buckets com controles mais fracos

Ou seja: muitas empresas protegem o “golden bucket”, mas esquecem do rastro que ele gera e dos seus irmãos de backup.

—

Casos reais (e o que eles ensinam)

Case 1: Asset público, código privado

Uma empresa de SaaS usava S3 para servir JavaScript e CSS de um app web. O bucket desses assets era público, como esperado. Em algum momento, um desenvolvedor subiu, por engano, um bundle de front-end com parte da lógica de acesso interno, incluindo URLs internas de API e uma chave obsoleta de debug ainda válida em um ambiente semi-produtivo.

O bucket não estava “vazando banco de dados”, mas fornecia informações suficientes para um atacante deduzir:

– Estrutura de endpoints internos

– Padrões de autenticação

– Ambientes auxiliares pouco monitorados

O atacante não precisou explorar o bucket; ele usou o que aprendeu ali para pivotar para outro ponto fraco.

Lição: o conteúdo de um bucket público é tão crítico quanto as permissões do bucket. Arquivos “não sensíveis” também podem ter metadados ou código que abrem portas.

—

Case 2: Backup em cold storage, sem revisão de política

Outro caso comum: uma empresa moveu dados antigos para um storage mais barato, incluindo backups cifrados com chaves próprias. Meses depois, trocou a arquitetura para KMS gerenciado, revisou políticas dos buckets principais, mas… nunca revisitou os buckets de cold storage legados.

Um integrador externo teve conta comprometida; a partir dali, um atacante encontrou chaves antigas e scripts de migração que apontavam para esses buckets “esquecidos”. Os dados estavam criptografados, mas:

– As chaves antigas ainda eram importáveis

– Havia documentação interna no próprio bucket explicando o processo de restauração

A exposição não veio de um bucket “de produção”, e sim de artefatos de migração mal higienizados.

—

Case 3: Auditoria só em produção, nada em dev & sandbox

Um time de segurança configurou bem as políticas de produção, com as melhores práticas configuração buckets s3 armazenamento em nuvem, incluindo bloqueio de público, criptografia obrigatória e logs de acesso. Porém, ambientes de dev, QA e sandbox ficaram fora das regras prescritivas.

Como é típico, dados de produção eram clonados para testes “pontuais” em dev, usando scripts manuais. Um developer com laptop comprometido subiu dumps para um bucket temporário em uma conta de desenvolvimento, sem nenhuma política de hardening.

Vazamento veio dali, e não da conta principal. O mesmo padrão se repete em GCP Storage, Azure Blob e outros proveedores.

—

Como evitar vulnerabilidades na prática (sem viver apagando incêndio)

Princípios de arquitetura que realmente funcionam

Antes de olhar para ferramentas, vale ancorar alguns princípios. Sem eles, qualquer solução vira remendo.

Pontos-chave:

– Separação radical de domínios: público vs privado, produtivo vs não produtivo, dados sensíveis vs dados operacionais

– Menor privilégio “de verdade”: roles por aplicação e serviço, não por time ou projeto genérico

– Imutabilidade de políticas em produção: mudanças via IaC e revisão, nunca por console na pressa

Esses fundamentos tornam a segurança em storage cloud como evitar vulnerabilidades um problema de design replicável, não um conjunto de proibições desconectadas.

—

Configuração segura básica (que muita gente ainda não fez)

Quando se fala em configuração segura de storage cloud para dados sensíveis, alguns itens são quase “checklist mínimo” — mas ainda aparecem como gap em auditorias.

Coisas que precisam ser padrão:

– Bloqueio global de acesso público, com exceções extremamente explícitas

– Criptografia em repouso com KMS (gerenciado) e rotação periódica

– Logs de acesso habilitados e enviados para um bucket de logs com política ainda mais restrita

– Versionamento + proteção contra deleção (object lock / retention / soft-delete) para evitar ransomware e sabotagem

Isso vale para S3, GCS, Azure Blob e serviços compatíveis; muda o nome do recurso, não o conceito.

—

Controles avançados e “twists” não óbvios

Aqui entram as soluções menos óbvias, que reduzem bastante a superfície de ataque, especialmente em buckets públicos ou semi-públicos.

Algumas estratégias interessantes:

– Storage atrás de gateway de identidade: em vez de usar URLs públicas, expor o acesso a objetos por meio de uma API gateway + autenticação OIDC; o bucket em si fica privado

– URLs pré-assinadas com política de contexto: gerar links com TTL curto e escopo reduzido, acoplados a claims do usuário e limites de IP / device quando possível

– Catálogo de classificações: atrelar labels de sensibilidade aos buckets (e aos prefixos) e fazer com que IaC e políticas usem esses labels para aplicar guardrails automáticos

O segredo é reduzir ao máximo a necessidade de “abrir exceções manuais”, que costumam ser mal documentadas e durar para sempre.

—

Ferramentas, automação e auditoria contínua

Ferramentas para auditoria e hardening de buckets cloud

Em 2026, fazer segurança de storage “no olho” é simplesmente impraticável em qualquer ambiente com mais de meia dúzia de contas. Ferramentas para auditoria e hardening de buckets cloud são obrigatórias, seja nativas do provedor, seja de terceiros.

Tipos de ferramentas que valem o investimento:

– Scanners de configuração que detectam buckets públicos, ACLs permissivas, ausência de criptografia e logs

– Motores de policy-as-code (como OPA / Rego ou equivalentes proprietários) rodando em CI/CD para bloquear deploys inseguros

– Agentes de “cloud posture management” que monitoram drift e alertam em tempo quase real sobre problemas

O truque profissional é acoplar essas ferramentas ao fluxo de desenvolvimento. Não adianta só rodar relatório mensal se, no dia a dia, o time consegue criar buckets inseguros em segundos.

—

Integração com CI/CD e “security gates” inteligentes

Um bom padrão é tratar buckets e storages cloud como qualquer outro recurso de infraestrutura versionada. Ou seja: tudo via Terraform, Pulumi, CDK ou similar.

Boas práticas que funcionam bem:

– Pipelines que falham se o plano tentar criar bucket com acesso público sem justificativa formal

– Policies centrais de organização (Org Policies, SCPs, Blueprints) que proíbem alguns tipos de configuração em toda a organização

– Jobs de verificação diária que comparam o estado real da nuvem com o código-fonte da infraestrutura

Isso reduz a quantidade de correções manuais, que são caras, lentas e propensas a erro humano.

—

Alternativas arquiteturais: nem tudo precisa ser bucket

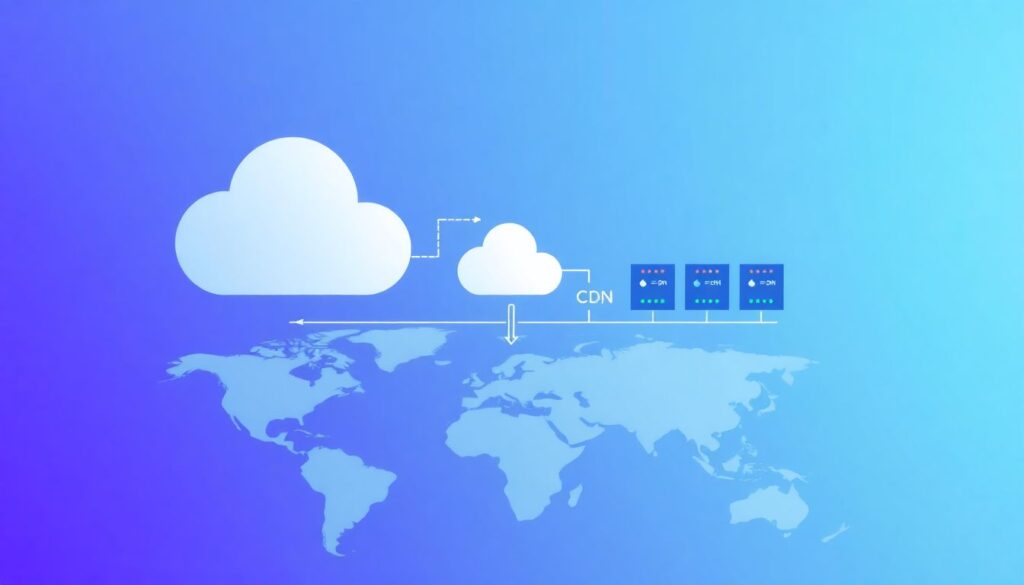

CDN, object proxy e armazenamento “de fachada”

Muita coisa que é jogada em bucket público poderia, na verdade, ser servida por uma CDN ou por um proxy de objetos, com regras de acesso mais sofisticadas. Você pode ter um bucket privado e expor apenas o que for necessário por um nível intermediário.

Algumas alternativas úteis:

– Usar CDN com origem privada (S3 origin access control / private origin em outras clouds)

– APIs que leem objetos do bucket privado, reformatam ou filtram metadados sensíveis e respondem ao cliente

– “Storage virtual” para clientes externos: eles acham que acessam “um bucket”, mas na prática falam com um serviço intermediário

Isso é especialmente relevante quando dados sensíveis e não sensíveis estão logicamente relacionados, mas precisam ser expostos de forma seletiva.

—

Separação física e lógica entre domínios

Outra abordagem subestimada é o uso agressivo de múltiplas contas, projetos e subscriptions. Em vez de apenas separar por bucket, você separa por boundary de controle inteiro.

Benefícios:

– Falhas de permissão em uma conta não afetam buckets de outra

– Chaves, roles e políticas ficam mais específicas por domínio de negócio

– Auditoria e billing ficam mais transparentes, ajudando a detectar uso anômalo

Não é a solução mais simples para times pequenos, mas a médio prazo reduz muito a superfície de ataque.

—

Lifehacks de profissionais que lidam com storage todos os dias

Pequenos ajustes que evitam grandes dores de cabeça

Alguns “truques” práticos que raramente aparecem em documentações oficiais, mas fazem diferença enorme na rotina.

Sugestões:

– Naming disciplinado: incluir no nome do bucket indicações como `-pub`, `-priv`, `-logs`, `-backup` e `-pii` para facilitar políticas e alertas orientados a padrão de nome

– Etiquetas como fonte de verdade: usar tags/labels como `data_classification=restricted` e fazer com que políticas de organização e scanners reajam a essas tags

– KMS estrito: uma chave KMS dedicada para cada domínio de dados sensíveis crítico (ex.: financeiro, saúde), com acesso só a serviços específicos

E, sempre que possível, padronizar “blueprints” de buckets: em vez de criar cada bucket a partir do zero, ter módulos de IaC que já vêm com logging, criptografia, bloqueio de público e retention configurados.

—

Monitoramento comportamental e honeypots

Para ambientes maduros, já faz sentido ir além do “está público ou não”. Alguns profissionais têm usado:

– Honeypots de buckets: buckets deliberadamente não críticos, monitorados agressivamente; qualquer acesso anômalo ali aciona investigação

– Detecção de anomalia de acesso: alertas se um bucket “silencioso” começar a ver picos de download, ou se surgir padrão geo incomum

– Marcação de documentos com canary tokens: arquivos falsos com payloads de rastreamento (como URLs únicas) que disparam alerta se forem abertos fora do ambiente esperado

Essas técnicas não impedem má configuração, mas ajudam a detectar exploração mais cedo.

—

Previsão para os próximos anos (além de 2026)

Automação cada vez mais forte (e mais exigente)

Olhando de 2026 em diante, a tendência é clara: menos tolerância a configuração manual e mais dependência de automação guiada por políticas. Provedores já oferecem assistentes de configuração que usam IA para sugerir permissões mínimas com base no uso real, e isso só deve se intensificar.

Em alguns anos, é bem provável que:

– Criar um bucket público direto no console gere alertas agressivos e justificativa obrigatória

– Configurações de storage inseguras sejam bloqueadas por padrão em contas corporativas

– Ferramentas de “auto-remediação” apliquem correções automáticas em buckets que violarem baseline de segurança

A discussão sobre melhores práticas configuração buckets s3 armazenamento em nuvem tende a sair de artigos técnicos e virar política corporativa pré-embarcada em contas enterprise.

—

Classificação automática de dados e confidencialidade por padrão

Outra linha forte é o uso de modelos de classificação automática. Os próprios provedores (e vendors terceiros) já fazem inspeção amostral de conteúdo (quando autorizado) para rotular PII, dados financeiros, código-fonte sensível etc.

Caminho provável:

– Buckets marcados automaticamente como “sensíveis” ao detectar certos padrões de dados

– Políticas dinâmicas de acesso que endurecem assim que o sistema identifica aumento de criticidade

– Alertas de desvio de política se um bucket sensível receber permissão pública, mesmo que temporária

Isso empurra as organizações para uma cultura onde a configuração segura de storage cloud para dados sensíveis não é só boa prática, mas um requisito operativo automático.

—

Menos “bucket thinking”, mais “data perimeter”

Finalmente, a própria noção de bucket como fronteira primária deve perder peso. Os provedores vêm investindo em conceitos como “data perimeter” e “zero trust data access”, onde:

– O que importa é quem é o sujeito (identidade) e de onde está vindo (rede / device / app)

– O bucket vira só um storage engine; o controle de acesso vem de camadas acima

– Dados podem ser fisicamente espalhados, mas logicamente protegidos por políticas consistentes

Nesse cenário, perguntas como “como proteger buckets públicos na nuvem evitar vazamento de dados” passam a ser parcialmente substituídas por “como garantir que nenhum dado sensível chegue sequer perto de um contexto público sem ser mascarado ou filtrado”.

—

Fechando: o que fazer agora, na prática

Para não ficar só na teoria, um plano enxuto que você pode começar a aplicar já:

– Mapear todos os buckets / storages por conta/projeto, rotulando: público/privado, sensível/não sensível, produtivo/não produtivo

– Padronizar criação via IaC com módulos seguros (criptografia, logs, bloqueio de público, retenção)

– Implantar pelo menos um scanner contínuo e uma camada de policy-as-code para impedir regressões

– Revisar especialmente logs, backups, dumps e buckets “temporários”, que são os grandes esquecidos

A partir daí, dá para ir adicionando camadas: gateways, classificação automatizada, honeypots, monitoração comportamental. Segurança duradoura em storage cloud não vem de um único produto ou checklist, mas de uma combinação de arquitetura sólida, automação consistente e cultura de engenharia cuidadosa.