Contexto histórico e por que hardening em Kubernetes importa em 2026

Em 2014, quando o Kubernetes saiu do Google como projeto open source, pouca gente imaginava que em pouco mais de uma década ele seria o “sistema operacional” da nuvem. Lá por 2018–2020, a maioria das empresas ainda rodava clusters próprios ou começava tímida nos serviços gerenciados. A partir de 2022, com incidentes públicos de vazamento de chaves, criptomineradores em clusters e ataques de supply chain, o assunto “hardening kubernetes na nuvem” deixou de ser papo de time de segurança hardcore e virou preocupação de diretoria. Em 2026, com workloads de IA, dados sensíveis e compliance pesada, deixar cluster exposto virou luxo que ninguém pode pagar.

—

Entendendo o cenário dos clusters gerenciados

Da instalação manual ao “clicar e usar” em cloud

Se antes era comum manter um cluster montado na unha, hoje a realidade é outra. Serviços como EKS, AKS e GKE assumem papel central, facilitando upgrades, alta disponibilidade e integração com o ecossistema da nuvem. Só que esse conforto traz uma armadilha: muita gente acha que “gerenciado” significa “seguro por padrão”. Não é bem assim. O provedor cuida do plano de controle, mas as brechas geralmente aparecem na configuração das workloads, permissões exageradas, segredos mal guardados e exposições desnecessárias. Este guia hardening cluster kubernetes gerenciado existe justamente para cobrir esse “meio do caminho” que a cloud não assume por você.

O modelo de responsabilidade compartilhada na prática

Cada provedor de cloud bate na mesma tecla: segurança é compartilhada. E isso vale em dobro para Kubernetes. O provedor garante a segurança física, da rede base, do control plane e de alguns componentes de gerenciamento. Você é responsável pelas políticas de acesso, design das namespaces, uso de secrets, imagens de containers, e por como os pods conversam entre si e com o mundo externo. O erro clássico de iniciante é achar que o cluster vem “pronto para produção” só porque foi criado pelo wizard da console. Em 2026, os atacantes já sabem explorar defaults fracos; então aceitar tudo padrão é praticamente um convite aberto para problemas.

—

Passo 1 – Comece pela superfície de exposição do cluster

Tratar o API server como “porta de entrada do castelo”

O primeiro ponto de atenção é o acesso ao servidor de API, que é o coração do cluster. Em ambientes gerenciados, o provedor oferece opções como acesso público, privado ou híbrido. A tentação é deixar público para “facilitar o CI/CD” e o acesso da equipe, mas isso amplia a área de ataque. Priorize sempre endpoints privados, acessados via VPN, peering ou bastion host bem auditado. Ative autenticação forte, usando identidade da própria cloud (IAM Roles no AWS, Managed Identities no Azure, Service Accounts no GCP) e evite ao máximo usuários locais estáticos com certificados perdidos em laptops. Cada credencial esquecida vira possível porta para invasor paciente.

Erros comuns ao expor o cluster para a internet

Um tropeço frequente é deixar o endpoint da API exposto com regras de firewall amigáveis demais, confiando só em autenticação. Outro vacilo: criar exceções temporárias “só para testar” e nunca removê‑las. Em 2026, scanners automáticos procuram APIs de Kubernetes abertas e tentam força bruta, exploits de versões antigas de kubectl e tokens vazados. Se você realmente precisar de acesso público, restrinja por IP, ative MFA nas identidades usadas e monitore logs de autenticação com carinho. Para iniciantes, uma boa regra prática é: se você não consegue explicar em um parágrafo como alguém autoriza e audita o acesso à API, provavelmente está confiando demais no padrão do provedor.

—

Passo 2 – Autenticação e autorização (RBAC) bem desenhadas

Identidades humanas: nada de “adminzão para todo mundo”

Para pessoas, esqueça contas genéricas tipo “dev-team-admin”. Use grupos de identidade centralizados na cloud e dê permissões mínimas necessárias. Uma prática madura é separar perfis: quem só precisa ler logs fica em grupo somente leitura; quem aplica manifests de um namespace não deveria conseguir mexer no cluster inteiro. Crie roles específicas e use RoleBindings por namespace em vez de ClusterRoleBinding por preguiça. Muita gente se complica ao clonar permissões de um usuário “sênior” só para economizar tempo. Isso funciona até alguém cometer um erro em produção com um kubectl mal digitado, ou até uma conta ser comprometida e o atacante ganhar superpoderes em segundos.

Service accounts e tokens de aplicação

Para workloads, use service accounts dedicadas a cada aplicação ou conjunto de serviços relacionados. O padrão antigo de usar a default service account do namespace é um atalho perigoso, ainda muito comum em times que migraram apressados para cloud. Para hardening kubernetes na nuvem, pense em cada pod como entidade independente: ele deve ter apenas os acessos de API realmente necessários. Revise se é mesmo preciso listar pods de todo o cluster, ou se basta ler configmaps do próprio namespace. Desative automount de tokens em pods que não usam Kubernetes API. Aprenda a tratar esses tokens como segredos valiosos, com rotação e escopo limitado, e não como detalhe de configuração.

—

Passo 3 – Namespaces, multitenancy e isolamento

Separar ambientes e times desde o início

Uma forma simples e poderosa de melhorar segurança kubernetes em provedores de cloud é usar namespaces como “fronteiras lógicas”. Não misture desenvolvimento, homologação e produção no mesmo namespace; isso facilita confusões e acessos indevidos. Em ambientes maiores, é comum separar por domínio de negócio ou por equipe. O ponto central é que RBAC, quotas de recursos e políticas de segurança passam a ser aplicadas de forma bem específica. Para quem está começando, a dica é: desenhe mapa de namespaces no papel primeiro, pensando em quem deve falar com quem. Esse exercício evita aquela bagunça em que tudo acaba caindo no namespace default.

Network Policies como “firewall interno” do cluster

Sem Network Policies, todo pod fala com todo pod, em qualquer namespace. Em um cluster pequeno e experimental, isso parece inofensivo; em produção, é receita de catástrofe. Implemente políticas de rede declarando quem pode se comunicar com quem, usando labels coerentes. Comece restrito e vá liberando o necessário, em vez de fazer o contrário. Erro clássico: definir NetworkPolicy, mas esquecer que o CNI precisa suportá‑la, ou deixar uma política muito aberta “para resolver problema de conexão rápido” e deixar assim para sempre. Trate essas regras como faria com um firewall corporativo: toda exceção deve ter justificativa e, de preferência, data de validade clara.

—

Passo 4 – Segurança de imagens e supply chain

Registrar, escanear e assinar imagens sempre

Não há hardening consistente se as imagens já vêm contaminadas. Use registries privados da própria cloud e evite puxar imagens direto do Docker Hub em produção. Ative varredura de vulnerabilidades automática e quebre o build se algo crítico aparecer sem correção possível. Adote assinatura de imagens (como Sigstore/cosign) e configure o cluster para só rodar o que for assinado por chaves confiáveis. Em pipelines, trate dependências base de imagens com muito ceticismo, preferindo bases mínimas. O erro de principiante é usar imagens gigantes, cheias de pacotes desnecessários, pois isso amplia a superfície de ataque e dificulta atualização rápida quando uma falha grave é descoberta.

Políticas de admissão como guardiões de entrada

Admission controllers e ferramentas como OPA/Gatekeeper ou Kyverno são essenciais para aplicar melhores práticas de segurança kubernetes em cloud de forma automática. Eles deixam você bloquear deployments que usem imagens não aprovadas, privilégios excessivos, ausência de limites de recurso ou contêineres rodando como root. Sem isso, cada time improvisa e esquece detalhes importantes sob pressão. Cuidado para não começar com políticas duras demais sem fase de “audit” primeiro; isso gera atrito e pode derrubar deploys legítimos. Uma abordagem saudável é começar auditando, ver o que seria bloqueado, ajustar regras e só então ativar o modo enforcement em etapas controladas.

—

Passo 5 – Segredos, configurações sensíveis e criptografia

Tirando segredos de manifests e repositórios

Segredo em YAML versionado em Git foi quase padrão de mercado por muito tempo. Hoje, em 2026, isso é considerado falha grave, especialmente com tantas integrações e backups automáticos. Use mecanismos gerenciados como AWS Secrets Manager, Azure Key Vault ou GCP Secret Manager integrados ao cluster, ou pelo menos o Secret com criptografia em repouso habilitada e KMS da cloud. Ferramentas como External Secrets ajudam a conectar esses mundos sem copiar valor sensível para todo lado. A dica para iniciantes: faça uma busca por “password”, “token” e “secretKey” nos repositórios de código e trate cada ocorrência em texto puro como dívida de segurança a ser paga imediatamente.

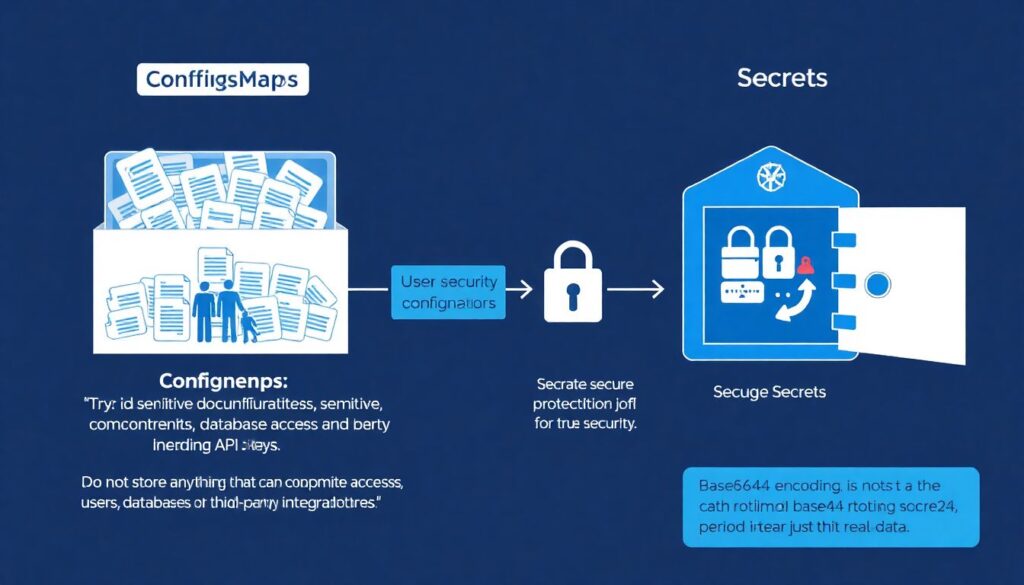

Boas práticas na utilização de ConfigMaps e Secrets

ConfigMaps são para configuração não sensível, mas muitas vezes acabam virando depósito de “meio segredo” por conveniência. Evite guardar qualquer coisa que possa comprometer usuário, banco ou integração de terceiros ali. Para Secrets, ative rotação periódica e não confie que o fato de estarem base64 significa criptografia. No lado do aplicativo, minimize logs de valores sensíveis; de nada adianta proteger o Secret se o app despeja credenciais em stack traces. Outro erro recorrente é dar a pods acesso a segredos que eles não usam, simplesmente porque é mais fácil montar tudo num volume único. Esse hábito explodirá na sua mão no primeiro incidente sério.

—

Passo 6 – Restrição de privilégios nos pods e nos nós

Princípio do menor privilégio na prática do dia a dia

Um dos pilares do guia hardening cluster kubernetes gerenciado é encarar cada contêiner como um processo suspeito até que prove o contrário. Use PodSecurity Standards ou políticas equivalentes para proibir root containers, montagem de volumes sensíveis do host e capacidades extras de kernel sem necessidade. Configure seccomp, AppArmor ou equivalentes quando disponíveis no serviço gerenciado que você usa. Para majority das aplicações web, não há justificativa real para rodar como root. Erro comum é manter essa configuração porque “a imagem oficial veio assim” ou porque corrigir permissões de pasta no container parece chato. O trabalho agora é pequeno perto do esforço de forense depois de um ataque.

Tratar os nós como infraestrutura crítica

Em serviços gerenciados, muita gente esquece que nó worker ainda é responsabilidade do time. Mantenha versões de sistema operacional atualizadas, siga imagens endurecidas recomendadas pelo provedor e não instale agentes aleatórios no host sem bom motivo. Utilize grupos de nós separados para workloads com necessidades especiais, como pods privilegiados ou que acessam dispositivos específicos de hardware. E não misture, por exemplo, jobs de data science experimentais com serviços de produção críticos no mesmo pool. Falhas de isolamento nesse nível muitas vezes não aparecem em testes básicos, mas são exploradas por atacantes mais avançados que buscam justamente atravessar fronteiras entre workloads.

—

Passo 7 – Observabilidade, auditoria e resposta a incidentes

Coletar logs é só metade do caminho

Ativar logs de audit do Kubernetes e do provedor é fundamental, mas não basta empilhar dados em um bucket esquecido. Envie esses registros para uma plataforma de observabilidade que permita correlação e alertas. Foque em eventos como criação de service accounts poderosas, uso de ClusterRoleBinding, alterações de Network Policies e tentativas falhas de autenticação no API server. Configure alertas de comportamento incomum, como aumento súbito de pods consumindo CPU ao máximo em namespaces que antes eram tranquilos. Falta de visibilidade é o erro mais perigoso: muitos incidentes em 2026 ainda são descobertos meses depois porque ninguém estava olhando para sinais óbvios.

Planejar antes do incidente, não depois

Segurança efetiva exige que a equipe saiba o que fazer quando algo der errado. Defina um playbook de resposta para incidentes em Kubernetes: como isolar namespace suspeito, revogar credenciais, pausar deploys automatizados e coletar evidências sem destruir informações úteis. Treine esse processo com simulações periódicas, inclusive envolvendo times de desenvolvimento e produto. Uma dica para iniciantes é começar simples: documente passo a passo como você derrubaria um pod comprometido e restauraria uma versão segura. A partir disso, vá cobrindo cenários mais complexos como sequestro de credenciais de cloud a partir do cluster ou exfiltração de dados por canais discretos.

—

Passo 8 – Particularidades de AWS, Azure e GCP

Navegando pelas opções de serviço gerenciado

Quando falamos de kubernetes gerenciado seguro aws azure gcp, o desafio não é só técnico, mas também de entender o modelo de cada provedor. No AWS EKS, por exemplo, a integração com IAM é extremamente poderosa, mas se mal usada vira festival de policies amplas demais. No AKS, o casamento com Azure AD e Managed Identities facilita muito a autorização fina, desde que você não caia na tentação de usar credenciais locais “só para testar”. Já no GKE, Workload Identity reduz a necessidade de chaves de serviço tradicionais, mas exige que você tenha clareza de mapeamentos entre service accounts e permissões de GCP. Estude docs específicos, não confie só em defaults.

Usando recursos nativos de segurança a seu favor

Cada provider hoje oferece um arsenal de ferramentas de segurança Kubernetes em provedores de cloud, como scanners integrados, posture management e recomendações automáticas. Não ignore esses painéis só porque parecem “marketing”. Em muitos casos, eles apontam configurações objetivamente perigosas: serviços expostos sem necessidade, roles com wildcard em recursos sensíveis, clusters rodando versões sem suporte. A armadilha é tratar esses alerts como “ruído” e nunca priorizá‑los. Crie fluxo claro: alerta relevante gera ticket, ticket tem dono e prazo para correção. Com o volume de recursos em 2026, quem não automatiza esse filtro acaba soterrado e deixa passar justamente o problema mais crítico.

—

Conclusão – Hardening como processo contínuo, não projeto pontual

Fazer hardening kubernetes na nuvem não é um checklist que você marca uma vez e esquece. É um ciclo: revisar configurações, atualizar componentes, ajustar políticas, ouvir feedback dos times e acompanhar evolução das ameaças. Em 2026, os atacantes já sabem lidar com Kubernetes tão bem quanto muitos engenheiros de plataforma. A diferença entre um incidente grave e um susto bem gerido costuma estar na disciplina com que você aplica pequenas boas práticas todos os dias. Comece simples, priorize o básico bem feito – controle de acesso, segredos, rede e imagens – e vá amadurecendo. O importante é não ficar parado confiando apenas no fato de estar usando um serviço gerenciado.