Por que a rede na nuvem virou ponto crítico

Nos últimos três anos a superfície de ataque em cloud cresceu mais rápido que muitos times conseguem acompanhar. O relatório IBM Cost of a Data Breach 2023 mostrou que 82% dos incidentes analisados envolveram dados armazenados em ambientes cloud ou híbridos, e a Verizon DBIR 2023 reforçou que o movimento lateral dentro da rede continua sendo fase-chave em ataques bem-sucedidos. Em outras palavras, o problema já não é só “entrar” na sua nuvem, mas o que o invasor consegue fazer depois que ganha um pé lá dentro. Daí a importância de pensar desde cedo em uma arquitetura de rede segura na nuvem que trate segmentação, microsegmentação e controle de tráfego leste‑oeste como fundamentos, não como “extras” que vão ser adicionados em algum sprint futuro qualquer.

Conceitos-chave: segmentação, microsegmentação e leste‑oeste

Vamos alinhar o vocabulário antes de falar de ferramentas. Segmentação de rede para segurança em nuvem é dividir o ambiente em zonas ou VPCs/VNets com políticas diferentes: produção isolada de desenvolvimento, workloads regulados separados de não regulados, e assim por diante. Microsegmentação vai além: em vez de pensar por “zonas”, você controla quais workloads, pods ou até processos podem falar com quais destinos, na prática aplicando o princípio de menor privilégio em nível de fluxo. Já o controle de tráfego leste‑oeste em data center e nuvem mira no tráfego interno, entre serviços, que historicamente sempre foi mais confiado. Nos últimos anos, vários ataques de ransomware bem-sucedidos exploraram justamente lacunas nesse tráfego interno, onde quase não havia inspeção nem autenticação forte.

Ferramentas e blocos de construção necessários

Para tirar essas ideias do papel, você precisa combinar recursos nativos de nuvem com camadas adicionais. Em AWS, Azure ou GCP, os blocos básicos são VPC/VNet, sub-redes, Security Groups, listas de controle de acesso e gateways. Em cima disso, entram firewalls de próxima geração, muitas vezes em modo virtualizado, e soluções de SDN e de service mesh, como Istio, Linkerd ou AWS App Mesh, que ajudam a fazer microsegmentação de rede em cloud computing com granularidade por serviço. Ferramentas de observabilidade e fluxo, como VPC Flow Logs, Azure NSG Flow Logs e soluções tipo Datadog, New Relic ou Grafana Tempo, tornam visível o tráfego leste‑oeste para você não operar “no escuro”. Finalmente, plataformas de segurança como Prisma Cloud, Wiz ou Microsoft Defender for Cloud ajudam a detectar desvios de configuração e reforçar as melhores práticas de segurança de rede na nuvem de forma centralizada.

Passo 1: mapear dependências e definir domínios de confiança

Antes de criar a primeira subnet, você precisa entender como seus sistemas conversam hoje. Nos últimos três anos, falhas de mapeamento foram motivo frequente de downtime em migrações de rede, segundo relatórios da Uptime Institute. O processo começa com um inventário de aplicações, bancos, filas, APIs e integrações externas. Use dados de fluxo reais, extraídos por ao menos 30 dias, para enxergar padrões sazonais e não depender só da memória da equipe. Agrupe workloads em domínios de confiança: “frontends internet-facing”, “serviços de negócio”, “bancos regulados”, “ferramentas de operação”, entre outros. Esse agrupamento lógico servirá de base para os domínios de rede físicos (VPCs, sub-redes) e para políticas Zero Trust posteriores. Quanto mais você entender as dependências atuais, menor o risco de “cortar” um fluxo essencial sem perceber.

Passo 2: desenhar a macro-segmentação da nuvem

Com os domínios de confiança claros, você pode desenhar a macro-segmentação: quantas VPCs/VNets serão usadas, como será a separação entre ambientes, qual padrão de conectividade (hub-and-spoke, full mesh, transit gateway, peering). Um padrão comum é ter uma VPC “hub” de serviços compartilhados (monitoramento, CI/CD, bastion) e VPCs “spokes” para domínios de negócio distintos, conectadas via gateways e controladas por firewalls centrais. Essa camada resolve grandes blocos: quem pode falar com internet, como SaaS críticos são acessados, onde ficam os pontos de inspeção de saída. O erro clássico é supercentralizar e criar um “gargalo de firewall” caro e difícil de escalar. Outro extremo é aceitar peering indiscriminado entre VPCs e perder o controle de quem fala com quem. O equilíbrio está em poucas rotas bem pensadas e em políticas declarativas, codificadas como infraestrutura.

Passo 3: aplicar microsegmentação e Zero Trust

Com a casa grande dividida, vem o detalhe fino: que serviços realmente precisam conversar? Em vez de liberar a subnet inteira para “a aplicação X”, defina políticas por workload, rótulo ou identidade. É aqui que um service mesh brilha, porque transporta identidade criptográfica mTLS de serviço para serviço e permite políticas como “apenas o serviço de API pode falar com o banco de pedidos na porta 5432”. Seguindo pesquisas da Google e da Microsoft, empresas que adotam Zero Trust em nível de serviço conseguem reduzir em até 50% o raio de impacto médio de um incidente, porque o atacante encontra “paredes” a cada novo salto. Para não travar o negócio, comece em modo “observação”: registre o tráfego, proponha políticas baseadas no uso real e só depois faça o enforcement estrito, com janelas de rollback bem definidas e métricas de erro monitoradas de perto.

Passo 4: orquestrar o controle do tráfego leste‑oeste

Não adianta ter políticas se você não enxerga o que acontece depois que as aplica. O controle efetivo do tráfego leste‑oeste passa por três camadas: roteamento, filtragem e observabilidade. No roteamento, mantenha simplicidade: rotas claras e previsíveis reduzem o risco de “bypass” de inspeção. Na filtragem, combine security groups mais permissivos (para reduzir gestão linha a linha) com firewalls ou policies de mesh mais granulares, que capturam contexto de identidade. Na observabilidade, foque em três perguntas: quem falou com quem, quando e por quê. Use dashboards que destaquem tráfego inesperado entre domínios de confiança distintos e configure alertas baseados em desvio de comportamento, não só em assinaturas de ataque conhecidas. Assim você identifica tanto o erro de configuração inocente quanto o movimento lateral persistente.

Ferramentas práticas para o dia a dia

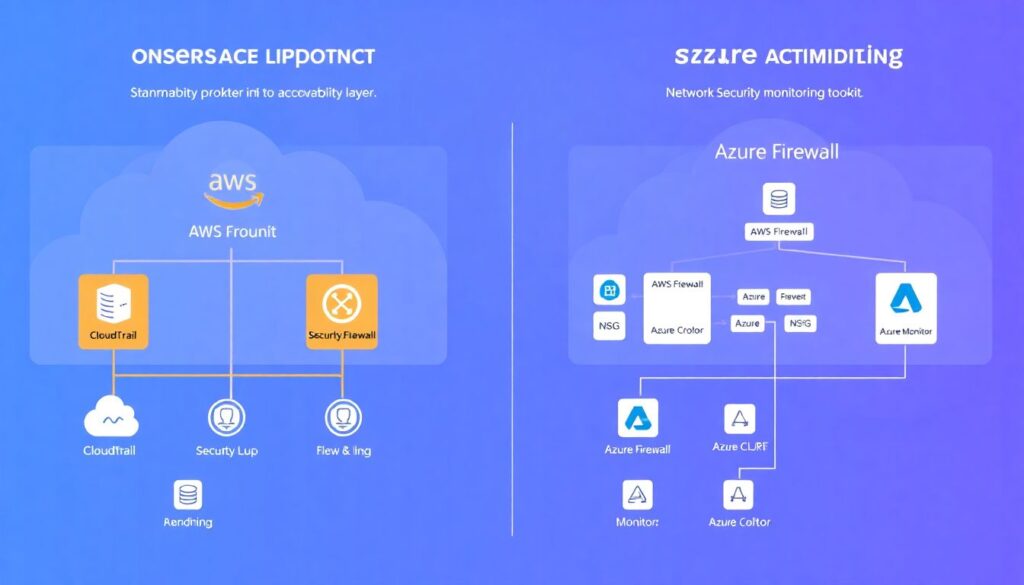

No cotidiano, vale padronizar um kit mínimo de ferramentas por nuvem. Em AWS, por exemplo, CloudTrail, VPC Flow Logs e Security Hub formam a base, complementados por um NVA (firewall virtual) e talvez AWS Network Firewall em pontos estratégicos. Em Azure, Azure Firewall, NSG e Azure Monitor oferecem controles similares, enquanto GCP conta com VPC Service Controls, Cloud Armor e Packet Mirroring. Em ambientes híbridos, soluções como Cisco ACI, VMware NSX ou ferramentas baseadas em eBPF ajudam a manter consistência de política entre on‑prem e cloud. Independentemente da pilha, a chave é tratar política de rede como código: tudo versionado, revisado por pares e aplicado via pipeline, não via clique manual no console. Essa disciplina reduz muito o risco de deriva de configuração ao longo do tempo.

Como estruturar o troubleshooting sem virar caos

Mesmo com o melhor design, alguma regra vai bloquear algo crítico em um domingo à noite. Para que o troubleshooting não dependa de “gurus” individuais, defina um fluxo padrão. Primeiro, confirme se o problema é realmente de rede: teste DNS, latência básica, logs de aplicação. Depois, verifique camadas de fora para dentro: borda de internet, firewalls centrais, roteamento entre VPCs, security groups, policies de mesh. Ter scripts prontos para testar conectividade (curl, mtr, tcpdump, ferramentas nativas de diagnóstico) economiza horas. Registre cada incidente relevante em runbooks e transforme as correções em mudanças de infraestrutura como código, evitando remendos manuais. Ao longo dos últimos anos, empresas que amadureceram essa abordagem conseguiram reduzir em mais de 40% o MTTR de incidentes de rede em ambientes cloud, segundo levantamentos internos de grandes provedores.

Fechando o desenho da arquitetura

Projetar uma arquitetura de rede segura na nuvem não é mais opcional; virou pré-requisito para qualquer operação séria em cloud. Quando você combina uma macro-segmentação clara, microsegmentação de rede em cloud computing bem planejada e visibilidade sólida sobre o tráfego interno, fica muito mais difícil para um atacante se movimentar sem ser notado. Isso não elimina risco, mas muda significativamente a assimetria do jogo a seu favor. Em vez de apostar em um único “muro” na borda, você cria várias camadas coerentes de proteção, alinhadas à forma como o negócio realmente funciona. Com estatísticas de violações e custos de incidentes subindo ano após ano, investir nessa “higiene estrutural” de rede tende a ser muito mais barato do que lidar com as consequências de um desenho frouxo daqui a dois ou três ciclos de orçamento.